文 | Morketing Lumens

近日有外媒报道称,由于人工智能“明星产品”ChatGPT的迅猛增长,OpenAI的年化收入已超过16亿美元,而这距离CEO奥特曼在10月表示的13亿美元年化收入仅仅只过去了两个月。

如果从数字上的对比来看,OpenAI的年度收入增长更为惊人。其2022年的年收入仅为2800万美元,甚至不及今年一周所带来的收入。

更重要的是,随着服务规模的扩大,OpenAI在首届开发者大会上宣布了大降价的消息,这意味着进一步降低的价格将为OpenAI带来更多的用户和更大的发展空间。同时开发者大会还透露了更多关于GPT Store的消息,而这被许多人认为将成为大模型的“AppStore时刻”。

作为大模型赛道目前的领跑者,OpenAI的一举一动都能成为整个AI赛道的引领和参考。因此,在OpenAI推出插件应用商店GPT Store之际对其盈利模式进行分析,我们或许能为国内外同类产品的商业化运作和未来发展提供一种可供参考的洞察维度。

OpenAI赚钱三大块:用户订阅、开发者付费和微软分成

自ChatGPT在2023年初爆火之后,随着OpenAI不断迭代产品,接连推出GPT-4、GPT-4 Turbo,其公司的商业模式也在迅速发展。经过2023年的探索和实践,OpenAI目前的商业模式可以分为三个部分:

第一部分是面向广大用户,也是个人消费者最可能接触到的会员订阅服务。从2023年年初开始,OpenAI就推出了名为ChatGPT Plus的会员订阅服务,用户可以通过每月支付20美元来得到更快的响应服务,同时能够优先使用功能更强大的GPT-4等模型。

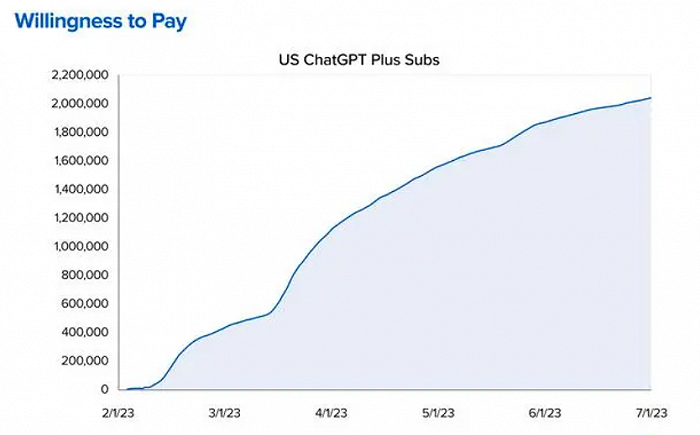

在付费用户规模方面,OpenAI尚未披露过明确的数字。不过根据美国风投公司A16Z的数据,仅到去年7月份,ChatGPT Plus的付费用户就达到200万左右。再加上OpenAI在去年11月份曾一度因为使用者激增暂时关闭了新付费用户的注册,因此可以推测其付费用户规模或许在百万级别。

此外,即将在近期推出的GPT Store预计也会对会员订阅服务产生更多影响。在去年11月份的首届开发者大会上,CEO奥特曼表示GPT Store会收录最受欢迎的GPT,同时进行创作者分成计划,这意味着GPT商店的出现会刺激用户数量和付费订阅规模的进一步增加。

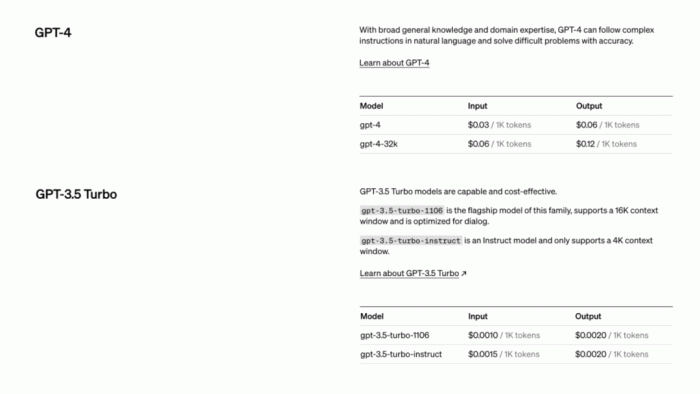

第二部分也是OpenAI最核心的收入,就是面向开发者的API接口调用收费模式。在这种模式下,开发者可以调用GPT系列大模型、DallE文字生成图片模型和语音识别模型等功能,而需要根据流量计费向OpenAI付费。

同样是在首届开发者大会上,OpenAI对API接口调用收费模式也带来了一场重磅升级,不仅带来了更新的GPT-4 Turbo模型,还来了一场大减价。在这次会议上,CEO奥特曼表示GPT-4 Turbo在输入方面成本是GPT-4的三分之一,而输出方面的成本则降到了二分之一,大大降低了用户的使用成本。

同时考虑到GPT-4 Turbo相比GPT-4的几大升级,包括更长的上下文长度、更强的控制、模型的知识升级、多模态等。这种“加量又降价”的行为将吸引更多的开发者以及企业将GPT技术应用到其产品和服务中,进而成为OpenAI的客户,逐步建立起围绕OpenAI的全新商业生态。

OpenAI商业化的第三部分收入则是来源于与微软的合作。在微软豪掷数十亿美元成为最大投资者之后,OpenAI和微软旗下的各类产品都有着密切的合作。Azure作为当下全球最大的几朵云之一,自去年年初和OpenAI共同推出了面向企业端客户售卖的Azure OpenAI。客户通过Azure云大模型的每一笔付费,OpenAI都可以获得相应的分成。

据了解,宜家、沃尔沃和可口可乐等公司都在通过微软的Azure云获得OpenAI的接口服务。这意味着,凭借着微软和众多大型企业的合作关系,OpenAI可以较为轻松地获得这些大企业的合作业务以及收入分成。

值得一提的是,OpenAI在上述商业化方面的成功远远超出了管理层的预期,公司的营收预期在2023年经历了数次上调。在去年早些时候,CEO奥特曼认为OpenAI在2023年的收入仅为2亿美元左右,而在9月这一数字增加到10亿,随后又上升到了13亿,如今的16亿美元年收入对比最开始的2亿预期早已翻了三番。

从这种增长速度来看,再加上OpenAI对接口服务的“大减价”,GPT的用户数量和覆盖范围很有可能会在2024年再上一个台阶。也正是由于这些原因,目前在产品技术和商业化都处于优势的OpenAI已经给出了2024年年化收入达到50亿美元的新目标。

硬件、运营、人力成本“三高”,员工薪酬超2亿

不过就在年化收入坐火箭般增长的同时,OpenAI作为处于人工智能前沿的科技公司,其科研投入和开支同样不菲,堪称一个“吞金兽”。

从OpenAI的商业运营模式来看,为了支撑其大模型产品的竞争力,OpenAI的开支主要分为三个部分:

一是开发大模型期间的硬件投入和训练成本。大模型作为计算机科学的前沿成果,自然和计算机、芯片等算力硬件离不开关系,微软向OpenAI投资的10亿美元以及后续追加的一百多亿美元就是在AI超级计算机和芯片上花了大头。据微软高管透露,为了提供足够的算力,搭建起的超级计算机配备了数万个英伟达A100GPU,并在60多个数据中心总共部署了几十万个英伟达GPU辅助。

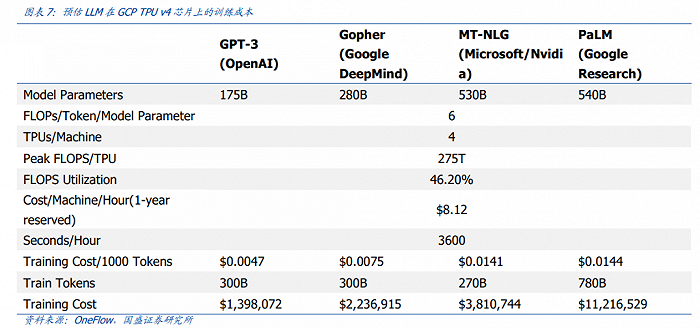

除了硬件费用外,大模型在开发期间的训练成本也是非常之高。根据国盛证券发表在去年2月的报告《Chatgpt 需要多少算力》估算,GPT-3训练一次的成本约为140万美元,对于更大的LLM模型,训练成本介于200万美元至1200万美元之间。需要指出的是,这里提到的是GPT-3的单次训练成本,后面推出的GPT-3.5、GPT-4等数据量更多的模型,其训练成本也只会更多不会更少。

二是日常运维成本。国外媒体Analytics India Magazine在去年曾对OpenAI的日常运行成本做出估算,它推测称OpenAI为了保持ChatGPT的正常运行就需要每日耗费约70万美元成本。而且在GPT大火之后,访问量的暴增也会直接导致日常运行成本的成倍上涨。

三是高昂的人力成本。IT行业作为智力密集型行业,工程师的平均薪酬本就相对较高,在OpenAI所在地旧金山就更是如此。之前有报道称,由于OpenAI的员工中有许多机器学习领域的大佬,在公司仅有300多名员工的情况下,整个公司的薪资成本在2亿美元以上。

而随着谷歌、Meta等巨头也在大模型赛道努力追赶,为了防止员工的流失,OpenAI势必要再次提高薪酬待遇来将员工留下来。

此外,需要注意的是,上面所提到的OpenAI各种收支情况基本上都处于AIGC商业化的第一个阶段即尝鲜阶段。在《AIGC未来已来 迈向通用人工智能时代》这本书中,作者将AIGC的商业化分为了三个阶段,分别是:感知冲击-尝鲜阶段、认知领悟-协助阶段、新生态链-原创阶段。

从目前主流的聊天机器人以及文字生成图片、视频等多媒体产品来看,现在的AIGC尚处于通过图片和视频等形式满足用户尝鲜需求的第一阶段。大多数人追捧AI的原因只是因为这是从未出现过的新事物,需要从使用体验上满足好奇心。

而如何让AIGC超越简单的辅助,成为虚实融合的重要载体,乃至更进一步地完成独立创作、原创内容等任务就成了OpenAI等公司的未来目标。毕竟当用户们对AIGC越来越熟悉,失去尝鲜的动力之后,用户和企业自然而然地会对人工智能的生产力方面提出更高的要求,如果届时OpenAI拿不出令人满意的产品升级,用户的付费意愿想必会大打折扣。

OpenAI的16亿美元年收入卖的是什么?

当我们分析OpenAI年收入目标从2亿美元到16亿美元的飞跃时,与其说OpenAI卖的是产品,不如说他们更多的是在兜售人们对于人工智能技术的尝鲜体验和未来畅想。

但是在尝鲜过后,这些新技术只要在更多的实践中体现出价值,才能从科技噱头走向与实践结合的商业化新阶段。不然只会像机器人领域的波士顿动力公司一样,虽然其产品性能表现处于世界前列,但由于在现实中没有太多应用场景,其公司几乎一直在亏损和被出售中徘徊。

而经过2023年一整年的热闹之后,生成式AI行业其实是存在着未来会“变冷”以及会持续热潮这两种声音。

认为会持续热潮的观点自然不必多说,而认为会变冷的观点主要集中在各国对AI限制法案的出台、AI模型训练内容侵权引起的争议,以及许多公司由于AI工具带来的好处无法覆盖其成本和风险,这部分客户会从AI领域中撤出。整个行业也将经历一轮整合,淘汰一部分参与者。当然这里说的变冷只是相比于2023年的火热而言,AI行业的“变冷”更像是往正常发展区间的一次回调。

虽然目前的硅谷巨头们都非常看好AI的发展,但在人工智能发展史上,已经有过三次“AI寒冬”,再宏大的技术愿景也会有因各种现实限制化为泡影的可能。而把这个道理放到OpenAI身上就意味着,ChatGPT想要在未来继续大火,必须要有在新鲜感之外明确证明自己价值的能力。

评论