文|半导体产业纵横

内存技术作为计算机系统的核心组成部分,其性能的提升对于整体计算能力的提升至关重要。在这个背景下,高带宽内存(HBM)以其卓越的性能表现,正逐渐在内存技术领域崭露头角,成为推动计算领域进入全新时代的关键力量。

相较于传统的动态随机存取内存(DRAM),HBM的性能优势显而易见。

01、远远超越DDR

DDR 是一种常见的计算机内存类型,最早是为了提高内存传输速率而设计的。它采用了双倍数据传输技术,即在每个时钟周期内可以传输两次数据,从而提高了数据传输速率。

目前最常见的DDR版本是 DDR4、DDR5,但在过去还有 DDR3、DDR2、DDR等版本。每一代DDR版本都有不同的数据传输速率和性能。

DDR内存通常用于计算机的系统内存,用于存储操作系统和正在运行的应用程序等数据。

HBM是一种高带宽内存技术,专注于提供更高的内存带宽,尤其适用于高性能计算和图形处理领域。HBM的一个显著特点是,它使用了堆叠技术,将多个DRAM芯片垂直堆叠在一起,从而大大增加了数据通路,提高了内存的带宽。

因此HBM 具有可扩展更大容量的特性。不仅HBM 的单层 DRAM 芯片容量可扩展,HBM 还可以通过 4 层、8 层以至 12 层堆叠的 DRAM 芯片,此外HBM可以通过 SiP 集成多个 HBM 叠层 DRAM 芯片等方法,实现更大的内存容量。

HBM内存通常用于高性能显卡、GPU加速器以及需要大量数据传输的高性能计算应用中。

从功耗角度来看,由于采用了 TSV 和微凸块技术,DRAM 裸片与处理器间实现了较短的信号传输路径以及较低的单引脚 I/O 速度和 I/O 电压,使 HBM 具备更好的内存功耗能效特性。以 DDR3 存储器归一化单引脚 I/O 带宽功耗比为基准,HBM2 的 I/O 功耗比明显低于 DDR3、DDR4 和 GDDR5 存储器,相对于 GDDR5 存储器,HBM2 的单引脚 I/O 带宽功耗比数值降低 42%。

在系统集成方面,HBM 将原本在 PCB 板上的 DDR 内存颗粒和 CPU 芯片全部集成到 SiP 里,因此 HBM 在节省产品空间方面也更具优势。相对于 GDDR5 存储器,HBM2 节省了 94% 的芯片面积。

02、三大原厂的研发历程

目前的HBM市场主要以SK海力士、三星和美光三家公司为主。

2014 年,SK海力士与 AMD 联合开发了全球首款硅通孔HBM,至今已经迭代升级了4代HBM产品,性能和容量持续提升。2020年SK海力士宣布成功研发新一代HBM2E;2021年开发出全球第一款HBM3;2022年HBM3芯片供货英伟达。2023年8月,SK海力士推出HBM3E,11月英伟达宣布H200将搭载HBM3E。

可以说从HBM1、HBM2E、HBM3、HBM3E,SK海力士持续领先。2022年SK海力士占据HBM市场约50%的份额,三星占比40%,美光占比10%。

在很长一段时间内,SK海力士都是英伟达HBM的独家供应商。2023年SK海力士基本垄断了HBM3供应,今年其HBM3与HBM3E的订单也已售罄。

三星是在2016年,开始宣布量产4GB/8GB HBM2 DRAM;2018年,宣布量产第二代8GB HBM2;2020年,推出16GB HBM2E产品;2021年,三星开发出具有AI处理能力的HBM-PIM;虽然三星的路线图显示2022年HBM3技术已经量产,但实际上三星的HBM3在2023年底才正式完成验证,这意味着在大量生产之前,市场还是由SK 海力士垄断。

再看美光,2020年,美光宣布将开始提供HBM2内存/显存;2021年,HBM2E产品上市。为了改善自己在HBM市场中的被动地位,美光选择了直接跳过第四代HBM即HBM3,直接升级到了第五代,即HBM3E。随后在2023年9月,美光宣布推出HBM3 Gen2(即HBM3E),后续表示计划于 2024 年初开始大批量发货 HBM3 Gen2 内存,同时透露英伟达是主要客户之一。

03、HBM2e过渡到HBM3e

HBM的概念的起飞与AIGC的火爆有直接关系。

AI大模型的兴起催生了海量算力需求,而数据处理量和传输速率大幅提升使得AI服务器对芯片内存容量和传输带宽提出更高要求。HBM具备高带宽、高容量、低延时和低功耗优势,目前已逐步成为AI服务器中GPU的搭载标配。

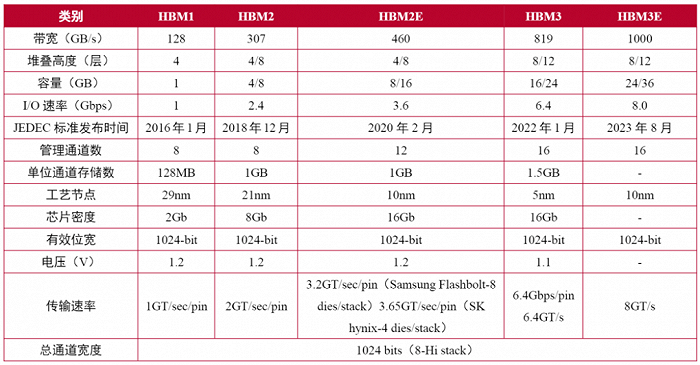

目前,HBM产品以HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的顺序开发,最新的HBM3E是HBM3的扩展版本。

来源:山西证券

HBM每一次更新迭代都会伴随着处理速度的提高。引脚(Pin)数据传输速率为1Gbps的第一代HBM,发展到其第五代产品HBM3E,速率提高到了8Gbps,即每秒可以处理1.225TB的数据。也就是说,下载一部长达163分钟的全高清(Full-HD)电影(1TB)只需不到1秒钟的时间。

当然,存储器的容量也在不断加大。HBM2E的最大容量为16GB,目前,三星正在利用EUV光刻机来制造24GB容量的HBM3芯片,此外8层、12层堆叠可在HBM3E上实现36GB(业界最大)的容量,比HBM3高出50%。

此前SK海力士、美光均已宣布推出HBM3E芯片,皆可实现超过1TB/s的带宽。

根据TrendForce集邦咨询调查显示,2023年HBM市场主流为HBM2e,包含NVIDIA A100/A800、AMD MI200以及多数CSPs自研加速芯片皆以此规格设计。同时,为顺应AI加速器芯片需求演进,各原厂计划于2024年推出新产品HBM3e,预期HBM3与HBM3e将成为明年市场主流。

04、HBM3e市场彻底被引爆

SK海力士无疑是这波内存热潮中的最大受益者,截至2023年12月31日,SK海力士在2023财年和第四季度的营收取得了显著增长。特别是其主力产品DDR5 DRAM和HBM3,在这一年的收入较去年上涨了4倍以上。

英伟达和AMD的下一代人工智能GPU预计将主要搭载HBM3内存。例如,H100是第一款支持PCIe 5.0标准的GPU,也是第一款采用HBM3的GPU,最多支持六颗HBM3,带宽为3TB/s,是A100采用HBM2E的1.5倍,默认显存容量为80GB。

2023年11月英伟达发布了新一代AI GPU芯片H200,以及搭载这款GPU的AI服务器平台HGX H200等产品。这款GPU是H100的升级款,依旧采用Hopper架构、台积电4nm制程工艺,根据英伟达官网,H200的GPU芯片没有升级,核心数、频率没有变化,主要的升级便是首次搭载HBM3e显存,并且容量从80GB提升至141GB。

得益于新升级的HBM3e芯片,H200的显存带宽可达4.8TB/s,比H100的3.35TB/s提升了43%。不过这远没有达到HBM3e的上限,海外分析人士称英伟达有意降低HBM3e的速度,以追求稳定。如果与传统x86服务器相比,H200的内存性能最高可达110倍。

由于美光、SK海力士等公司的HBM3e芯片需等到2024年才会发货,因此英伟达表示H200产品预计将在2024年第二季度正式开售。

AMD 的 MI300 也搭配 HBM3,其中,MI300A 容量与前一代相同为 128GB,更高端 MI300X 则达 192GB,提升了 50%。AMD称,MI300X提供的HBM密度最高是英伟达AI芯片H100的2.4倍,其HBM带宽最高是H100的1.6倍。这意味着,AMD的芯片可以运行比英伟达芯片更大的模型。

与此同时,在2023年随着AI GPU 以及与AI相关的各类需求激增,HBM价格也持续上涨。市场研究机构Yolo Group 报告显示,2023 年期间HBM 内存供需链发生了重大变化,生产水平和采用率同时大幅提高,使得 HBM 成为比人工智能热潮之前更有价值的资源,2023年 HBM 芯片的平均售价是传统 DRAM 内存芯片的五倍。

在HBM盛行的当下,没有一家存储厂商能够忍住不分一杯羹。

05、三大原厂为之“疯狂”

技术升级

SK海力士在SEMICON Korea 2024上发布了一项重要公告,公布了其雄心勃勃的高带宽存储器路线图。该公司副总裁Kim Chun-hwan透露,计划在2024上半年开始量产先进的HBM3E,并强调向客户交付8层堆叠样品。

HBM3E是SK海力士产品线的最新产品,可满足日益增长的数据带宽需求,在6堆栈配置中,每堆栈可提供1.2 TB/s和惊人的7.2 TB/s通信带宽。Kim Chun-hwan将这种进步的紧迫性归因于生成式人工智能的迅速崛起,预计将见证惊人的35%的复合年增长率(CAGR)。然而,他警告说,在不断升级的客户期望的推动下,半导体行业正在面临“激烈的生存竞争”。

随着制程工艺节点的缩小并接近其极限,半导体行业越来越关注下一代存储器架构和工艺,以释放更高的性能。SK海力士已经启动了HBM4的开发,计划于2025年提供样品,并于次年量产。

根据美光的信息,与前几代HBM相比,HBM4将采用更广泛的2048位接口。导致每个堆栈的理论峰值内存带宽超过1.5 TB/s。为了实现这些非凡的带宽,在保持合理功耗的同时,HBM4的目标是大约6GT/s的数据传输速率。这种更宽的接口和更快的速度将使HBM4能够突破内存带宽的界限,满足日益增长的高性能计算和AI工作负载需求。

三星是半导体行业的主要参与者,该公司也有HBM4的发布时间表,计划于2025年提供样品,并于2026年量产。三星高管Jaejune Kim透露,该公司的HBM产量的一半以上已经由专业产品组成。定制HBM解决方案的趋势预计将加剧。通过逻辑集成,量身定制的选项对于满足个性化客户需求至关重要,从而巩固了市场地位。

随着HBM3E的发布和HBM4的准备,SK海力士和三星正在为未来的挑战做准备,旨在保持其在HBM技术前沿的地位。不仅如此,全球前三大存储芯片制造商正将更多产能转移至生产HBM,但由于调整产能需要时间,很难迅速增加HBM产量,预计未来两年HBM供应仍将紧张。

扩产情况

再看三大原厂的扩产情况。据悉,SK海力士将扩大其高带宽内存生产设施投资,以应对高性能AI产品需求的增加。

去年6月有媒体报道称,SK海力士正在准备投资后段工艺设备,将扩建封装HBM3的利川工厂,预计到今年年末,该厂后段工艺设备规模将增加近一倍。

此外,SK海力士还将在美国印第安纳州建造一座最先进的制造工厂,据两位接受英国《金融时报》采访的消息人士透露,SK海力士将在这家工厂生产 HBM 堆栈,这些堆栈将用于台积电生产的 Nvidia GPU,SK 集团董事长表示,该工厂预计耗资 220 亿美元。

三星电子和 SK 海力士之间的竞争正在升温。三星电子从去年第四季度开始扩大第四代HBM即HBM3的供应,目前正进入一个过渡期。负责三星美国半导体业务的执行副总裁 Han Jin-man 在今年1月表示,公司对包括 HBM 系列在内的大容量存储芯片寄予厚望,希望它能引领快速增长的人工智能芯片领域。他在CES 2024的媒体见面会上对记者说,“我们今年的 HBM 芯片产量将比去年提高 2.5 倍,明年还将继续提高 2 倍。”

三星官方还透露,公司计划在今年第四季度之前,将 HBM 的最高产量提高到每月 15 万至 17 万件,以此来争夺2024年的HBM市场。此前三星电子斥资105亿韩元收购了三星显示位于韩国天安市的工厂和设备,以扩大HBM产能,同时还计划投资7000亿至1万亿韩元新建封装线。

为了缩小差距,美光对其下一代产品 HBM3E 下了很大的赌注,美光首席执行官 Sanjay Mehrotra 表示:“我们正处于为英伟达下一代 AI 加速器提供 HBM3E 的验证的最后阶段。”其计划于 2024 年初开始大批量发货 HBM3E 内存,同时强调其新产品受到了整个行业的极大兴趣。据悉,美光科技位于中国台湾的台中四厂已于2023年11月初正式启用。美光表示,台中四厂将整合先进探测与封装测试功能,量产HBM3E及其他产品,从而满足人工智能、数据中心、边缘计算及云端等各类应用日益增长的需求。该公司计划于2024年初开始大量出货HBM3E。

值得注意的是高阶HBM的竞争才刚刚开始,虽然目前HBM产品占整体存储的出货量仍然非常小,长期来看,随着消费电子产品向AI化发展,对于高算力、高存储、低能耗将是主要诉求方向,鉴于此预计HBM也将成为未来存储厂商的技术发展方向。

评论