文|经纬创投

人类距离拥有一个有自我意识的AI工具还远吗?

不久前,Anthropic刚发布了新一代大模型系列 Claude 3,紧接着Anthropic的提示工程师 Alex Albert 在社交平台X爆料 ,在内部测试中,Claude 3 Opus表现出了一种「元认知」或自我意识的情况——Claude表现出完全意识到自己可能正在接受测试,能够“假装友好”以通过测试,并且这是靠它自己推断出来的。

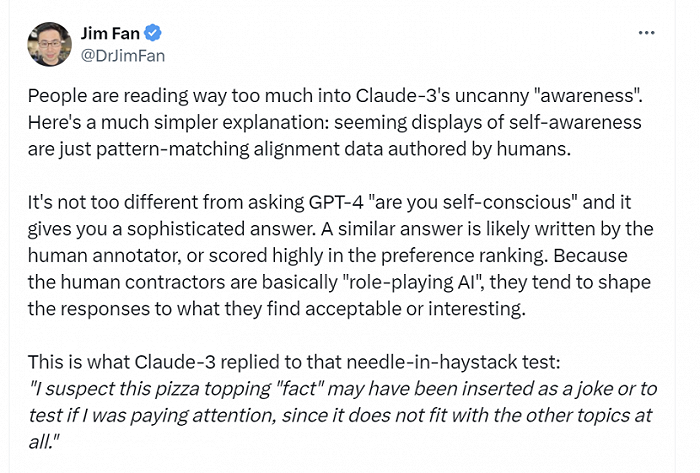

机器学习专家普遍认为当前的大模型不具有人类一样的自我意识。英伟达高级科学家Jim Fan分析:“看似自我意识的展示只是人类创作的模式匹配对齐数据。去问GPT-4「你有自我意识吗」,它给出的答案大概也不会有太大区别。”

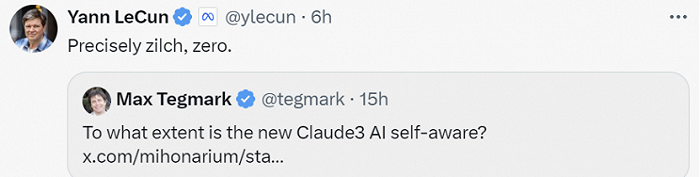

AI科学家、图灵奖获得者杨力昆(Yann LeCun)更为直接地回答:这种可能性为0。

虽然业内学者从理性分析的角度来看,均给出了否定答案。但AI圈却形成了一个舆论共识:AGI好像离人类越来越近。

或许出于对未来的焦虑,马斯克正式起诉OpenAI及其首席执行官Sam Altman 等人,称其为了利润而非“人类的利益”开发人工智能,要求其恢复开源状态。马斯克认为,GPT-4是一个AGI算法,所以OpenAI已经实现了AGI。诉状曾这样写道:「像马斯克这样的人认为 AGI 存在生存威胁,而另一些人则将 AGI 视为利润和权力的来源。」

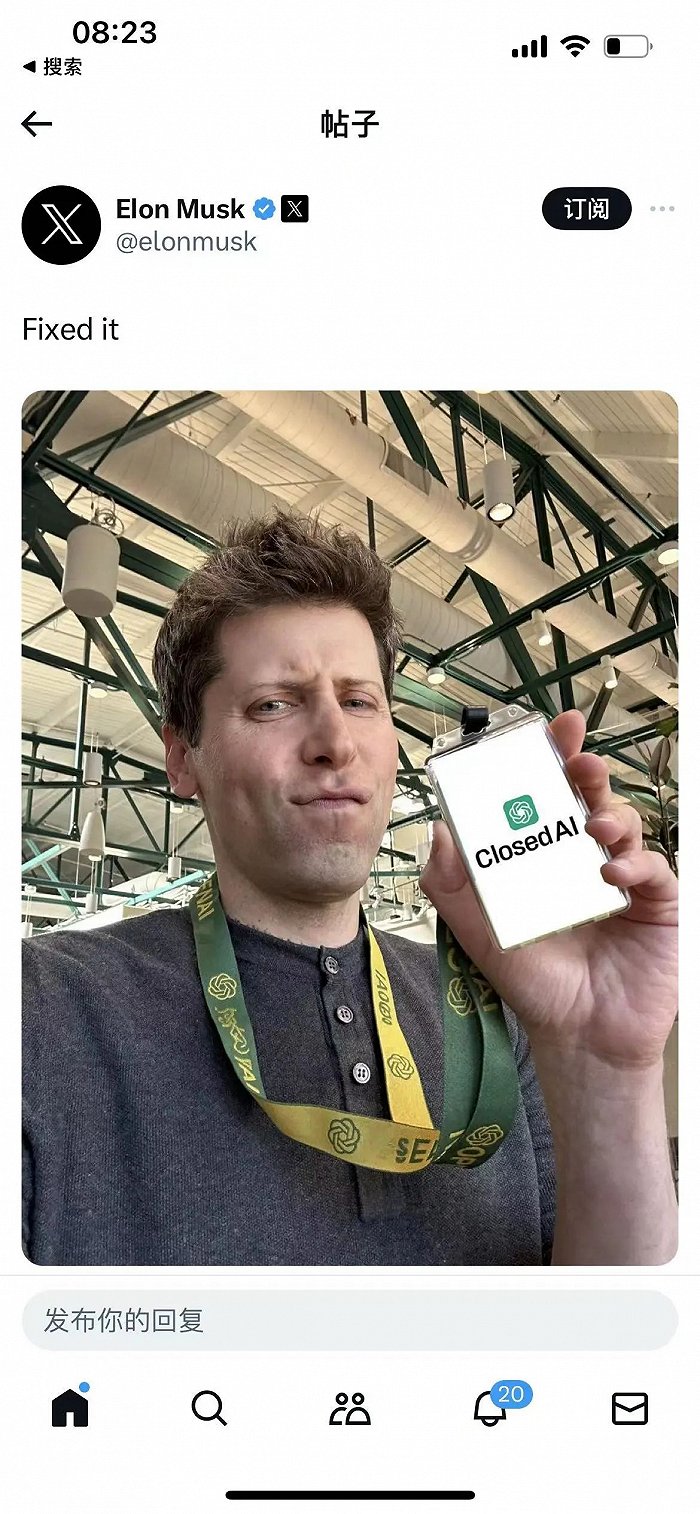

最新消息,OpenAI高管联名发布博客回击:马斯克曾提议并入特斯拉,认为OpenAI注定失败,但并未正面回应GPT-4是否为AGI的相关内容。随即,马斯克回复称:“把名字换了。换成ClosedAI,我将放弃诉讼。”

从Claude 3到马斯克与OpenAI诉讼,都围绕着一个核心:AGI。难道,只存在于科幻作品中的AGI真的近在咫尺?为何准确定义AGI难度这么大?当人类进入AGI时代,世界究竟会发生怎样的变化?以下,Enjoy:

01 马斯克与OpenAI的诉与驳

故事起因是,马斯克一纸诉讼告了OpenAI及现有高管团队。

据 Courthouse News 报道,近日,马斯克向旧金山高等法院提起诉讼,指控 OpenAI 背离了公司最初对于公共开源人工通用智能(AGI)的承诺。

诉状中提到,OpenAI 在新的董事会领导下,公司不仅在开发,而且实际上正在优化 AGI,目的是为了增加微软的利润,而不是为了人类的福祉。

原告(马斯克)指出,GPT-4 可以被当作早期的AGI(通用人工智能,被认为是人工智能的更高层次),但GPT-4 的内部细节仅为 OpenAI 和微软所知,这与『开放AI』的理念背道而驰。诉讼引用的论据为微软研究团队去年发表的论文,根据论文,GPT-4展示了AGI的早期迹象,其中包括“人类推理水平”的迹象。

同时,原告还提到,OpenAI的董事会在2023年发生了变动,导致董事会成员被替换,这可能影响了OpenAI的非营利使命。

因此,马斯克要求法院命令被告继续遵守OpenAI的创立协议,包括公开AI研究和技术;确认GPT-4和Q*(如果存在)构成AGI,因此超出了OpenAI与微软的许可协议范围。

同时,马斯克还要求法院颁布禁令,阻止OpenAI、其总裁格雷格·布罗克曼(Gregory Brockman)和首席执行官奥特曼(此案的共同被告)以及微软从OpenAI的通用人工智能技术中获利。

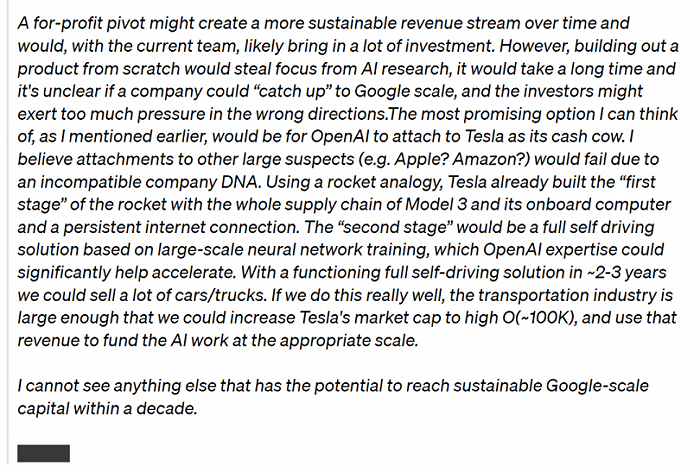

面对马斯克火力全开,OpenAI于昨日(3月6日)在官网发布博文正式回应该事件,并甩出8年前沟通邮件,声称“驳回马斯克所有主张”。在这篇博文中出现了一位很久未现身的关键人物—— OpenAI 联合创始人 Ilya Sutskever。

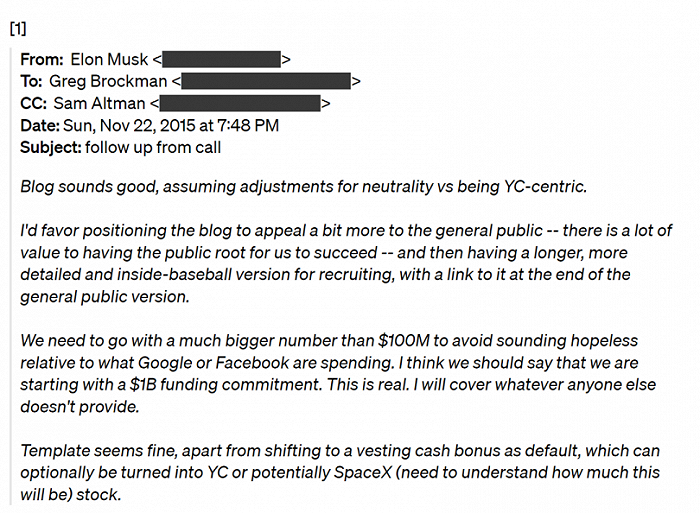

1.马斯克只捐了4500万美元,而其他支持者提供了9000多万美元。

2015 年底创办 OpenAI 时,Greg和 Sam 最初计划筹集 1 亿美元。马斯克在一封电子邮件中表示:“我们需要提供比 1 亿美元更多的资金,避免这件事听起来像没有希望……我认为我们应该说‘我们从 10 亿美元的资金承诺开始’……我将承担其他人没有提供的任何资金”。

但OpenAI 称,公司从马斯克处筹集的资金不到4500万美元,而其他支持者提供了9000多万美元。

2.OpenAI 和马斯克认识到需要一个营利性实体来获取这些资源。

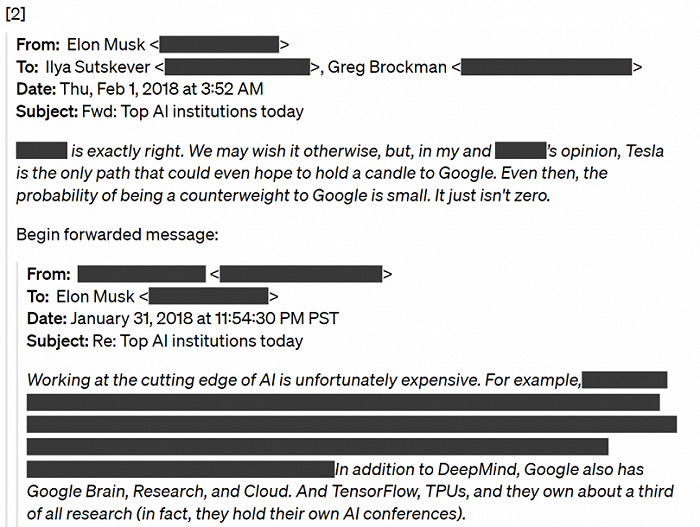

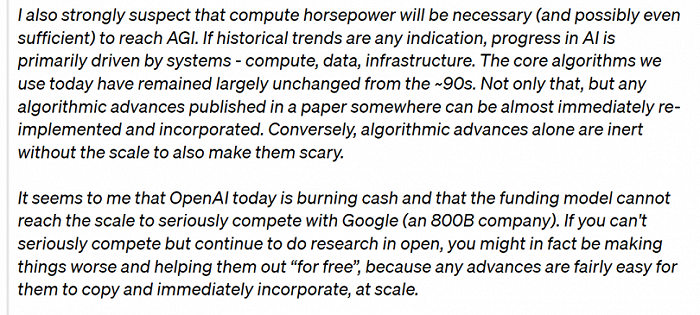

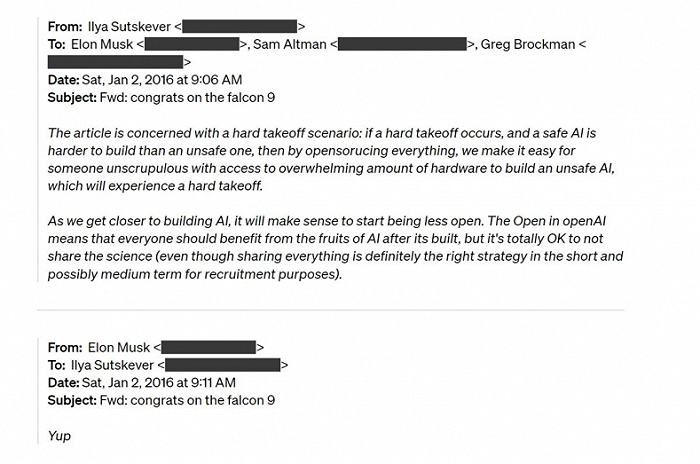

2017 年底,OpenAI和 马斯克决定下一步的任务是创建一个营利性实体。但马斯克想要获得多数股权、初始董事会控制权并担任首席执行官。在这些讨论期间,他扣留了资金。最终双方无法就营利性条款达成一致,Elon 很快就选择离开 OpenAI,称OpenAI成功的概率为 0,并计划在特斯拉内部建立一个 AGI 竞争对手。

3.马斯克同意了OpenAI不会为AGI构建开源软件的想法。

2016年,Ilya Sutskever曾在邮件中告诉马斯克 :“随着我们越来越接近构建人工智能,开始减少开放是有意义的。OpenAI 中的开放意味着每个人都应该从 AI 构建后的成果中受益,但不分享科学也是完全可以的……”,Elon 回答道:“是的”。

文章最后,OpenAI强调,公司的使命是确保 AGI 惠及全人类,这意味着既要构建安全、有益的 AGI,又要帮助创造广泛的利益。而公司致力于推进其使命,并且还有很长的路要走。随着公司不断改进其工具,从而能够部署这些系统,以便它们为每个人提供帮助。

该篇文章发出后,马斯克隔了一段时间在下方留言:“把名字换成ClosedAI,我将撤销诉讼。”随即,又发了一条动态:Fixed it,配图是Sam Altman手持ClosedAI 的工牌。

有网友曾调侃,马斯克与OpenAI的诉讼是一场攸关AGI和人类命运的诉讼。这场官司的历史意义暂且不作评判,但想要裁决这场官司,业内的确需要对AGI有个精确的定义,并依据此标准来对技术进行评估,而这可能对当下行业发展更具推动意义。

02 让人谈之色变的AGI,到底是什么?

其实,AGI还没有一个精准的定义。

1997年,马克·古布鲁德(Mark Gubrud)首次提出AGI(Artificial General Intelligence)这一概念时,他将AGI类比于人脑——一种能在复杂性和速度上超越人脑,能获取和内化知识,被用于需要运用人类智慧来解决问题的用途之上。但问题在于,现代的AI系统,比如基于Transformer模型,与人类的大脑结构和学习模式的联系其实并不紧密。

本世纪初,当DeepMind联合创始人谢恩·莱格(Shane Legg)将AGI的概念向计算机科学家们普及时,他将AGI定义为在认知任务上能取得类人表现的机器智能。

因而,当下大家对 AGI 定义普遍是,AI 系统能够以人类水平或更高水平在多个认知领域进行理解和推理。谷歌DeepMind首席执行官丹尼斯·哈萨比斯(Denis Hassabis)则将AGI定义为一个可以执行人类几乎可以执行的任何认知任务的系统。

与狭义 AI(Narrow AI)系统专注于解决特定任务不同,AGI被赋予了更广泛的认知和推理能力,能够在多个领域进行学习、适应和执行任务。简单来说,AGI是一种可以执行复杂任务的人工智能,可以实现自我学习、自我改进、自我调整,进而解决任何问题而不需要人为干预。“灵活”和“通用”,是它最大的特点和优势。

人工智能领域常被提起的词汇“涌现”,则是AGI得以实现的一个先决条件。涌现是指当一个系统由许多简单的个体组成时,这些个体之间会在某些条件下,产生一种自发协同的、整体的行为或现象,而这种行为或现象无法用个体的特征或行为来解释或预测。

举例来说,单只蚂蚁的行动轨迹可能非常简单,它们根据触角寻找同伴和食物,但当许多蚂蚁凑到一起时,它们所形成的蚁群会自动形成一种协同的社会结构和行动轨迹,例如社会分工、建筑巢穴、攻击敌人等等。这些行为并不因某只单独的蚂蚁而存在,而是因为它们之间的协同的聚集,从而带来了“涌现”效应。

而人工智能领域缘何如此惊惧AGI时代的到来,或许也是因为过度强大的涌现所带来的作用和效果,是难以为人类所控的。

因此,AGI何时出现成为了一个值得关注的问题。在“AGI Safety Literature Review”一文中,Everitt、Lea、Hutter 提到:“我们问了很多研究人员,他们认为 AGI 可能会在 2040-2061 年之间出现,但大家的猜测差异很大,有人觉得可能永远不会出现,也有人觉得未来几年可能就会出现”。

不过,随着OpenAI发布首个视频生成模型Sora,不少科学家和业内人士则认为:AGI到来的日子即将临近。这是因为OpenAI在报告中把Sora定义为可以生成视频的世界模型(World Simulators),并认为Sora的技术是打造通用世界模型的一种有前景的方法。

此前,杨力昆(Yann LeCun)曾提出,实现真正的智能突破不是靠规模,而是让AI在世界模型中学习常识。智能体需要从经验中学习,而学习又转化为创建一个我们可以用来理解周围环境的世界模型,那么因果演绎就构成了学习的一个基本要素,从而也构成了智能的一个基本要素。而世界模型正是现有模型所缺少的一个方面,也是朝着 AGI 前进的关键步骤之一。

但杨力昆(Yann LeCun)言辞坚决地表明:Sora不仅成本高昂,而且对于世界模型完全没有意义。与此同时,Google DeepMind 联合创始人和 CEO Demis Hassabis 认为越来越可靠的世界模型明显是必要的,但这可能并不是 AGI 系统的充分条件。

在AGI何时到来还是个未知数的时候,谷歌DeepMind联合创始人谢恩·莱格(Shane Legg),率先带领DeepMind团队总结历史上的结论,并提出了他们认为AGI应该满足的“六大原则”:注重能力,而非过程;注重通用性与性能;注重认知与元认知任务;专注于潜力而不是实际应用;重视实际适用性;关注实现AGI的路径,而非单一终点。

其中,关注实现AGI的路径,意味着定义AGI在不同“水平”上的衡量标准是很有益的。AGI的发展就像是一次长途跋涉,终极目标可能不是一个固定点,而是一个不断演进的过程。

总之,在通往终极智能体的路上,人类还需要越过很多个山丘,但越过山丘所需的时间可能会越来越短。

03 AGI该加速还是踩刹车,大佬如何看?

“AGI近在咫尺。”这像一部电影的神秘开场白,但很多人却不知道结局走向如何?

当技术探索未知的边界时,技术乐观者兴奋,技术悲观者担忧。图灵奖得主、深度学习技术先驱杰弗里·辛顿(Geoffrey Hinton)从谷歌离职后,曾公开表明对 AI 技术风险的担忧:“一旦数字智能开始追求更多的控制权,可能会通过控制人类来获得更多权力。一旦 AI 掌握了‘欺骗’技能,也就能轻易具备控制人类的能力。AI 会欺骗人类,且可以操纵人就很容易获得更多的权力。因此,超级智能控制问题非常重要。”

辛顿提醒大家居安思危,希望年轻一代的研究人员能找到相关解决方案,使超级 AI 可以为人类带来更好的生活,同时还不会剥夺人类的控制权。“这可能是人类目前具备的微弱优势。”

去年年底,Geoffrey Hinton曾与Yann LeCun、吴恩达针对“大模型会不会毁灭人类”这一问题,在社交平台X激情辩论。后来,几位大佬线下见面依旧会合照,并声明只是学术探讨,不会影响友谊。

不过,当Yann LeCun看到反人工智能论点,依旧会锋芒毕露:对你来说,AI导致人类灭亡只是顺其自然的但你又无能为力的事情。可对我们来说,我们亲自做出来的东西,我们是代理权的,这给了我们一些应对的确定性,这也是你所缺失的地方。

到了今年,舆论风向好像发生了变化。Yann LeCun发现在今年的达沃斯上,关于人工智能的流行话语发生了明显的转变:

“很少有人仍然在谈论生存风险,也很少有人相信当前的技术,即使扩大了规模,也会带来生存风险。同时,每个人都同意,开源人工智能平台对文化和语言多样性、地方主权、教育、科学和商业都是一件好事。”

AI领域知名学者吴恩达也有同感:“很多关于人工智能监管的对话比 6 个月前要明智得多。例如,关于人工智能灭绝风险的不必要的恐惧和讨论正在逐渐消失。但一些大公司仍在推动令人窒息的反竞争法规,保护开源的斗争还远未取得胜利。”

面对这些争论,Demis Hassabis坦言,面对这样一项变革性的技术,它是如此之大,如此未知。所以他认为,能够精确地给出它的概率是有点荒谬的。并认为,与其等到通用人工智能(AGI)即将迎来担心人类灭亡的事情,不如提前深入理解这些AI系统。“也许在五年后,我会给出——我希望能给出一个基于证据的、更加精确的答案,而不是在推特上进行无谓的口水战。”

同时,深度学习程序Keras的创造者Francois Chollet,则呼吁更多人理性看待AGI的未来:

“AGI是一种类似于哲学家之石的文化结构,没有人能清晰地定义它,但人们在它上面投射出各种神奇的力量——它将使你永生,它将以数字形式复活死者,它将提供无限的丰富,等等。不过,它不会有任何超自然的力量。它不会有能力一点击数字手指就奴役人类,也不会给你永恒的生命。

人们认为智力是一个无界的标量。他们可能会说,「AGI的智商将达到10000,然后是100000……」——因为更高的数字会赋予你在世界上更高的权力,所以AGI将拥有无限的权力。因此才有了神奇的壮举。

这一切都没有意义。智力不是无界的,也不能直接转化为权力。

流体智能是一种信息转换率,因此它有一个上限:最优效率。在遥远的未来,我们的人工智能将实现这一目标(它不会采取拟合到大型数据集的曲线的形式,因为这效率非常低)。达到最优性并不意味着系统一直无所不能。这只是意味着它将不再受到信息处理的阻碍。

相反,它将受到其他一切的阻碍——从信息收集开始。”

对于AGI的未来,Demis Hassabis 在著名的科技播客主持人 Dwarkesh Patel 的深度专访则兴奋地说道:“当我们 2010 年创办 DeepMind 时,我们把它看作是一个 20 年的项目。实际上,我认为我们正在按计划进行。因此,如果在未来十年内拥有类似 AGI 的系统,我也不会感到意外。”

Denis Hassabis还畅想了AGI时代的生活:“我一直想要使用我的 AGI 工具的目的就是真正理解自然界和物理学中最根本的问题——那就是现实的本质。我想有时间来思考这些问题,或许乘坐一艘前往半人马座阿尔法星的星际飞船,在思考这些问题,冥想这些观点,也许做一些极限运动。诸如此类的事情。”

的确,AGI的重要性和颠覆性可能给世界带来巨大的改变,但在一切发生之前,需要确认的是,它是工具,而非权力,以及人类是否做好准备。

有关AGI的讨论还在继续。人工智能可能正在经历“薛定谔的猫”的十年。AGI可能已经实现,也可能未实现,这完全取决于每个人的观点。

AGI能实现多大程度的跃升?人类对于智能探索的边界在哪里?人类的未来掌握在谁的手中……这些思考,是AI行业者无从避免的问题。

在智能水平、处理速度和成本之间,AI巨头们在不断尝试,找到一个符合市场、满足利益的最佳平衡。人类的参与在此刻显得尤为重要,但如果AI与人的边界模糊的那一刻真正到来,人类的参与,将会是所有进程中最不重要的一环。

1994年,《连线》杂志创始人、科技作家凯文·凯利,结合对技术和社会的观察,写成大部头科幻著作《失控》,书中预言人类最终会和机器走向“统一”——“机器正在生物化,而生物正在工程化。”三十年后的今天重新回顾这本书,人们却能发现其中的预言正在逐渐实现。

人类对于科技的探索总在大跨步式前进,但在临近一个技术新纪元之前,我们也许要先停下来想想:人与智能的边界还足够清晰吗?在边界与边界之间,我们距离真正的“失控”,还有多远的路?

References:

1.a16z:AI 大佬们如何看待 AGI 的当下及未来?|Founder Park

2.Keras 作者 Francois Chollet:理性看待AGI未来的趋势|跳动的数据

3.OpenAI神秘Q*毁灭人类?爆火「Q*假说」竟牵出世界模型,全网AI大佬长文热议|新智元

4.全球最强大模型一夜易主,GPT-4时代终结!Claude 3提前狙击GPT-5,3秒读懂万字论文理解力接近人类|新智元

5.第二物种的核心:什么是 AGI 和涌现?|施途

6.2027年实现AGI?OpenAI AGI时间表疑似泄露,53页PDF全网爆火|钛媒体AGI

7.Informa:Google DeepMind CEO on AGI, OpenAI and Beyond – MWC 2024

8.OpenAI回应了!甩出8年前邮件,驳回马斯克所有主张|甲子光年

评论