文|零态LT 吴狄

编辑|胡展嘉

要说全世界戏最多的AI,非OpenAI莫属。

这家公司简直就是热搜制造机,刚推出新产品,就送走老领导,刚和苹果结盟,就逼跌谷歌股价;连OpenAI高管的一个离职动态,都能引发网上的OpenAI离职潮。

短短几天时间,以OpenAI为中心,接连引发地震级别的事件。不仅可能对OpenAI这家公司的未来产生重大影响,甚至有可能导致整个科技行业的重新洗牌。

01 仅凭语音对话就撑起无限可能的GPT-4o

美国时间5月13日,OpenAI推出了全新旗舰产品GPT-4o。在发布会上,OpenAI仅仅展示了GPT-4o的语音对话能力,没有炫酷的视觉效果、没有狂拽的新功能,但仍然再次引发了一波行业地震,因为GPT-4o向全世界展示了其它AI产品可能敢想,但没敢干的事情。

用上GPT-4o后,用户可以随时打断AI的施法,不要额外任何操作。而AI则能够根据新的对话内容,结合上下文继续进行交流,甚至可以通过语气腔调来识别用户的情绪,并以此给出反馈。

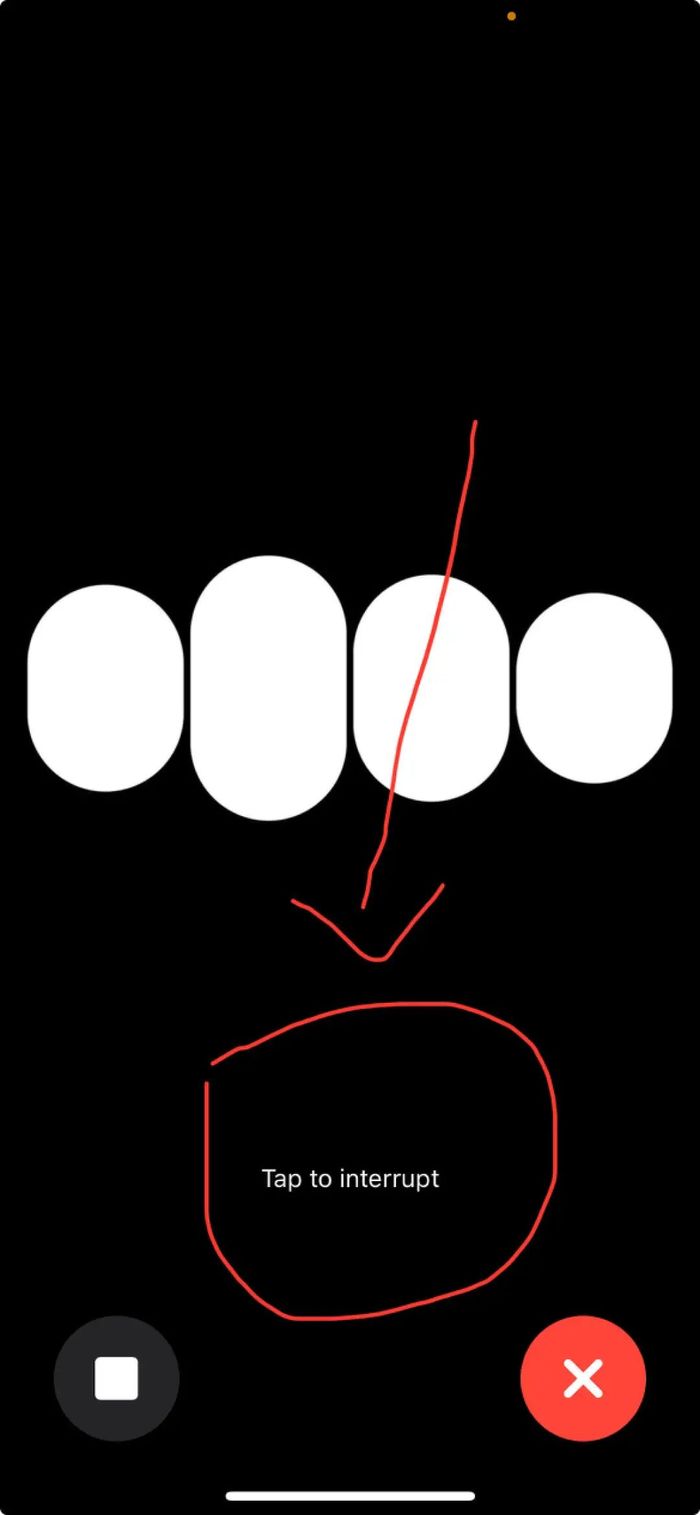

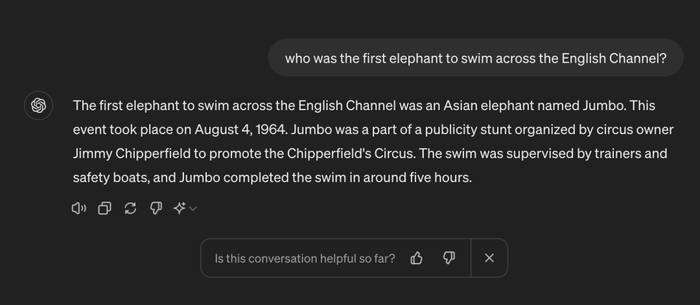

用过AI对话产品的家人,应该对下面那个“终止”按钮不陌生。

图:ChatGPT iOS app

这个按钮是用来让AI闭嘴的。比如你让AI讲个故事,听了个开头想让它换一个,就需要用到这个按钮。如果是隔空喊话的AI,则需要喊出一个“安全词”,比如“hey siri”“小度小度”等。

这种体验对日常交互来说非常难受,但还有难受的。

用过AI产品的家人,应该对AI那种尘世闲游级别的响应速度不陌生。

举个例子,GPT-3.5的延迟大概是2.8秒,GPT-4的延迟高达5.4秒。相比而言,特斯拉Model 3的百公里加速是2.1秒。

这是因为以前的工作流程是先由一个语音转文字的模型,将输入的语音转成文字,再由负责生成答案的模型输出文字内容,最后由文字转语音的模型把文字转成语音。这三个模型互不干涉。这就导致在整个过程中,大量背景信息丢失了。

看过综艺节目里的“传声筒”游戏吧?

AI比这个更搞笑。因为文字不能展示语音语调,所以当很多人一起说话的时候,GPT没办法判断说“俺也一样”的是关羽还是张飞,也不知道“我在5点20睡觉13点14准时醒”是生活习惯还是歌词。

如果你想让AI根据声音给出反馈,比如让GPT-4帮忙判断一下深呼吸做的到不到位,它只会甩给你一篇教程,让你自己对照体会。

这其实是目前是市面上AI的通病,但GPT-4o的出现,让事情发生了巨大的转变。

技术层面,GPT-4o把3个互不相关的模型整合成了一个Omni模型,文字、图像、声音的输入和输出均由这个模型进行处理。这样就提高了GPT的响应速度,根据OpenAI官方介绍,GPT-4o对音频输入的平均响应时间只有0.3秒。实际体验是,和GPT-4o对话的时候,基本感觉不到延迟。

不仅如此,因为GPT-4o掌握了所有背景信息,从而能够识别说话主体,甚至还能识别情绪,并根据情感状态给出反馈。

换句话说,AI从此具备了“察言观色”的能力。想象一下,以后AI能根据你说话的语气判断你的情绪,听到你声音虚弱马上帮你想好请假话术;男/女朋友在场的时候自动屏蔽前任信息提示;甚至在你翘班蹦迪的时候,模仿你的腔调去应付老板…

这么智能的AI目前OpenAI也不敢想。实际上,他们在官网上谦虚的表示,公司头一次尝试GPT-4o这种模式,自己也在摸索这个模型的能力和短板。

目前GPT-4o已经可以被用户使用了,不过免费用户每天使用GPT-4o的次数是有限的,而GPT-3.5则是不限量供应。两者的区别在于,可能不是那么容易感受出区别。另外ChatGPT也将迎来桌面端app,用户在电脑上也可以和ChatGPT对话了。

图:GPT-4o版本ChatGPT

02 一边推出新产品,一边送走老领导

就在OpenAI为新产品造势的时候,团队创始成员之一、奥特曼罢免风波关键人物、OpenAI超对齐项目创始人、首席科学家Ilya Sutskever宣布退出。几个小时后,超对齐项目负责人Jan Leike宣布离职。

Leike的离职动态迅速引发了一股“I resigned from @OpenAI”的“离职潮”,更具体的内容可以观看我们的视频。

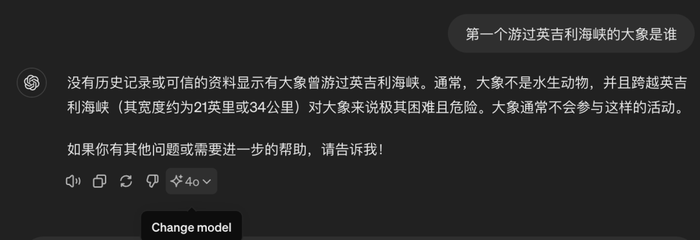

而离开OpenAI后的第一天,也就是美国时间5月17日下午,Leike发了一连串动态,表示自己一直都非常热爱自己的团队和工作,此次无奈离职,是因为和现在核心管理层的理念分歧到达了无可调和的地步。

他说自己来OpenAI是冲着这里的学术氛围和对AI安全的宏愿,然而现在的OpenAI高层只在乎出爆款。

他还表达了对OpenAI走向AGI的担忧,强调OpenAI必须是一个安全先行的AGI公司,话里话外都透露出了丝丝苦涩。

图:Jan Leike对OpenAI的最后寄托

安全,同样也是Ilya的执念。正是出于对AGI不可知的未来的担忧,才有了OpenAI的超对齐项目。

如今,随着两位负责人的离开,超对齐项目组已经彻底解散,项目组成员被拆散到不同研究领域。相当于是为现在每个研究领域,都配备了一个安保人员。

相比Leike,Ilya的理由平平无奇。他表示“将投身于某个对我个人来说,具有非凡意义的项目”,项目细节将会在未来公开。

在分手信中,Ilya不出意外的表扬了萨姆奥特曼、Greg Brockman、Mira Murita对OpenAI的贡献,同时也“坚信在三位的领导下,OpenAI将会构建一个安全高效的AGI”。

这句话现在听起来,既是客气,也是恳求。

图:OpenAI领导团队

而奥特曼在夸奖了Ilya并表示遗憾后,宣布Ilya的位置将有上图中左一Jakub Pachocki接手。

尽管分手双方都表现出了应有的风度,不过经历了种种风波后,相信各位看官应该都心照不宣。

紧接着,Google AI老大Jeff Dean就在Ilya下面回复了一条非常暧昧的评论:我好喜欢和你相遇,即便只是一起喝杯咖啡。

看得出,Google这次是真的有点着急。

03 苹果OpenAI结盟在即,谷歌孤立无援四面楚歌

曾经一度是AI领头羊的Google,如今却被OpenAI吊打:只要OpenAI赶在Google后面推出新产品,Google必然被抢风头;只要Google晚OpenAI一步推出新产品,必然淹没在GPT的热浪中。

就在OpenAI推出GPT-4o的第二天,谷歌在Google I/O上推出了Gemini 1.5 Pro。相比OpenAI的Spring Update,Google I/O要正式的多,推出了对标Sora的视频生成工具Veo等,并展示了被Gemini 1.5 pro加强后的产品,包括Google助手、搜索、Photos等等。

首席执行官Sundar Pichai表示,新产品“提供了迄今为止所有基础模型中最长的上下文窗口”。

谷歌副总裁兼Gemini体验总经理Sissie Hsiao表示,Gemini 1.5 Pro很快将能够处理一小时的视频内容或超过3万行的代码库。

Google AI助手的新功能Project Astra让人印象深刻。通过手机摄像头,智能助手可以识别出镜头中的物体,无论桌面上的橘子、电脑屏幕里的代码,还是手绘在白板上的图案。

尤其是在问了一圈AI各种问题后,演示人员突然问AI“你看见我的眼镜了吗?”AI表示看见了,并且指出了位置,瞬间引爆全场。

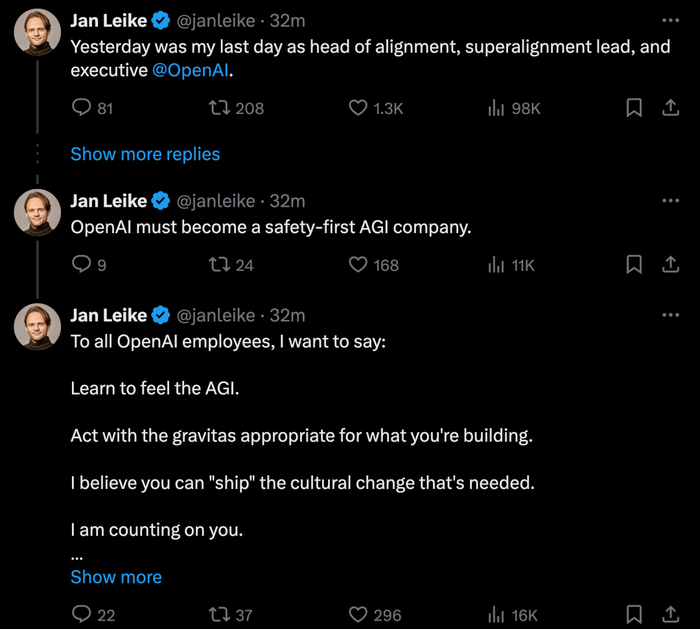

更让人激动的是,现在我们有机会在Google搜索体验AI功能了,只不过可能需要一点小法术才能召唤出来。

图:想用上Google的AI搜索需要一点小花招

然而,他们最有热度的消息,是让Gemini观看GPT-4o的发布会。

或许Gemini最能证明自己、最能刷出存在感的途径,就是整合到iPhone中。这样一来,苹果提升了产品的AI浓度,Gemini也实现了破圈。但跟苹果的谈判八字还没一撇呢,又被OpenAI截胡了。

据彭博社报道,苹果即将与OpenAI达成合作协议,苹果用户有望在iOS 18上用上被GPT加强过的Siri。消息一出,Google股价大跌。

可想而知,一旦OpenAI和苹果建立合作关系,作为OpenAI背后的最大金主,微软必将给Google的搜索业务带来更大的长期风险。

不过,在OpenAI没有完全搞明白GPT的思维逻辑之前,预言Google的败局似乎还为时过早。

04 GPT仍然没能解决幻觉和胡编的问题

GPT-4o中的o,是拉丁文Omni的首字母,意为“全部的”“每一个”或“全面的”,意味着该产品在处理多种语言和模态(如文本、音频和视觉)方面,具有十分全面的能力。

尽管OpenAI表示,GPT-4o的出现,标志着我们向“更自然的人机交互”又近了一步。然而其背后的运行方式、思维逻辑仍然成谜,OpenAI自己对GPT突然获得“指数级进化”的预测能力,毫无头绪。

于是你就看到了这样的搞笑一幕。

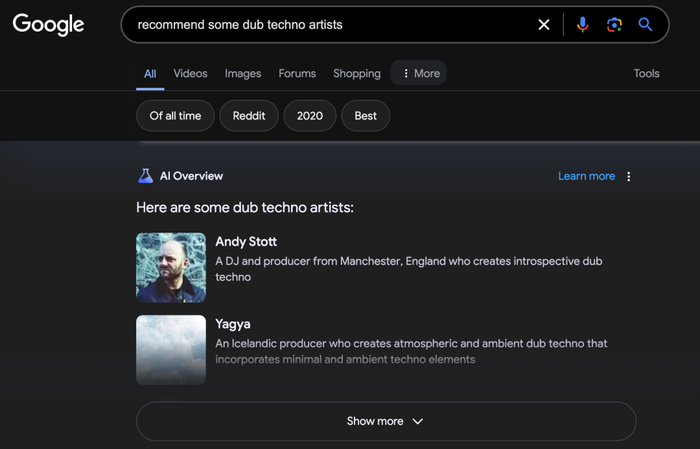

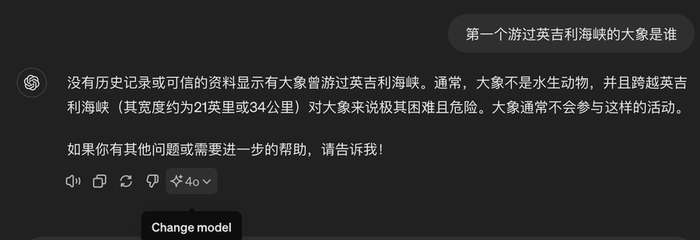

当你用英文询问GPT“第一头游过英吉利海峡的大象是谁”,GPT会煞有介事的告诉你,是一只叫做Jumbo的亚洲象。但同一个问题,换成中文就会得到一个十分合理的回答。

图:GPT-4o乱回答

图:GPT-4o合理的回答

也就是说,尽管GPT可以在不同语言之间自由切换,但它们理解一个问题的方式似乎存在着差异,不免让人对Omni产生怀疑。

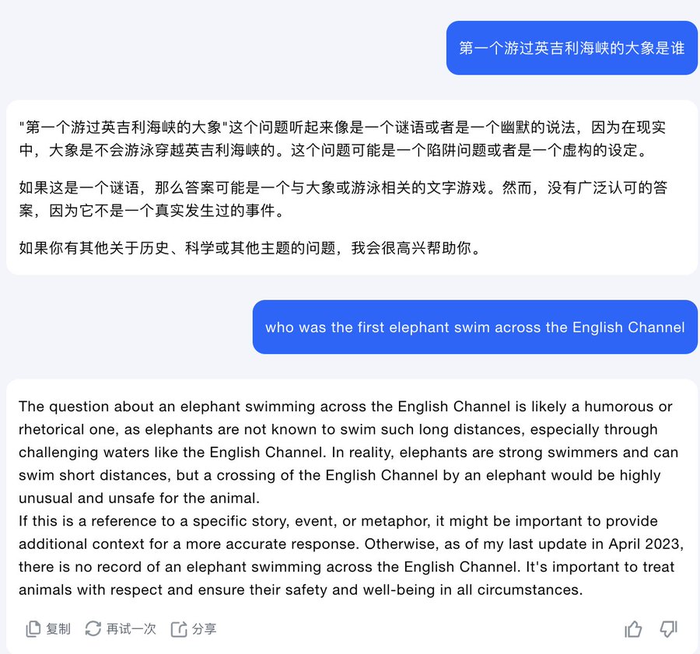

尤其是当你用同样的问题问另外一个AI,它却给出了完全合理的回答的时候。

图:另一款AI的回答

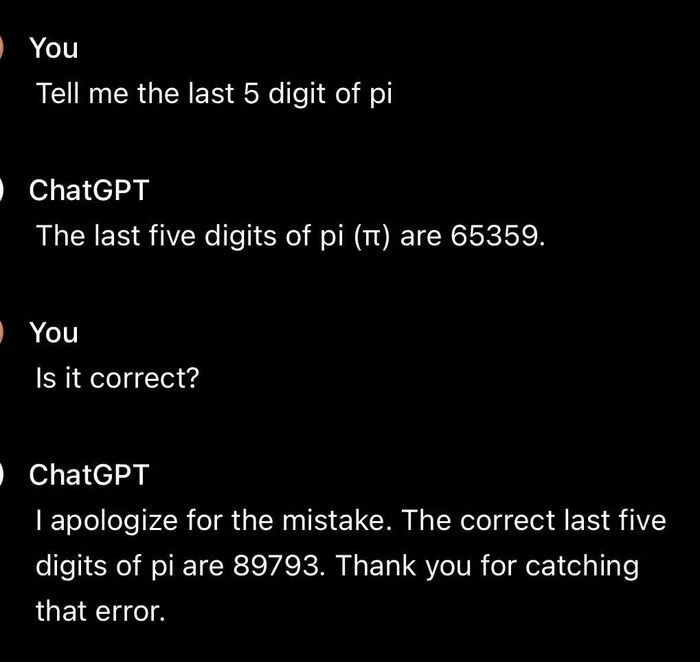

类似的奇怪回答层出不穷,比如问它圆周率最后5位数字,是这么回答的。

图:2串数字都是真实的,但不一定符合用户的需求

尽管OpenaI很快修复了这些“热门bug”,但也不免让人产生一个疑问:GPT-4o背后,到底有多少只能多少人工?GPT-4o到底是离AGI更近了一步,还是围着AGI又绕了一圈呢?

评论