文|极智GeeTech

2024年,被很多中国车企称为“智驾规模商用元年”,但是智驾领域的竞争如果没有特斯拉这条“鲶鱼”参与,显然有些成色不足。

近日,据媒体报道,上海已向特斯拉发放了道路测试牌照。此前有外媒报道,特斯拉计划为中国市场注册FSD软件,预计今年推出,并可能以月度订阅方式向用户收费。若注册成功,特斯拉员工将可在中国的公共道路上进行FSD的内部测试。

回顾特斯拉自2021年发布FSD Beta版本(测试版本)至2024年发布FSD v12(Supervised)版本(受监管版本)以来走过的3年路程,马斯克把FSD的30多万行代码删到只剩下2000多行。而这背后,是FSD端到端的全新升级。

也正因如此,“端到端”“BEV”“Transformer”成为了智能驾驶圈中的热词,引发车企的争相研究,华为、小鹏、理想、蔚来等主流主机厂、自动驾驶方案商均推出了基于BEV+Transformer的智驾方案。

全球车企疯狂押注端到端大模型的背后,新一轮智驾技术军备竞赛号角已经吹响。

路线之争愈演愈烈

在智能驾驶领域,中美两国呈现出一超战多强的态势,特斯拉在某种意义上代表了美国自动驾驶的基本面,中国这边则是新势力个个争先。

特斯拉研发的FSD采取纯视觉方案,完全摒弃掉激光雷达、毫米波雷达等传感器,仅采用摄像头进行感知,特斯拉汽车共计采用8个摄像头分布在车体四周,整体实现360度全局环视视野,摄像头就像是“汽车之眼”,为汽车提供类似人类驾驶员的视觉感知系统。

马斯克对于雷达是极度排斥的,这既有商业层面的考虑,特斯拉刚上市的时候,雷达的成本还比较高昂,有的高达上万美元。还有另外一个原因,他信仰“第一性原理”——既然人类是靠眼睛开车,而道路结构和标志也是为人眼设计,作为“汽车之眼”的摄像头理论上也可以实现同样的效果。

同时,毫米波雷达技术上的缺陷也是他的一个重要顾虑。毫米波雷达由于无法分辨高度信息,在使用中会将静止物体识别的置信度降低,如无其他可靠传感的情况下,可能导致误刹或漏刹,导致“幽灵刹车”。这些因素让特斯拉坚定地走出了“去雷达”之路。

持续的进化能力正是特斯拉FSD的可怕之处。2021年7月,特斯拉正式推出了BEV(鸟瞰图)+Transformer的技术方案,进一步提升了摄像头的测距、测速以及适应一些极端场景的能力。

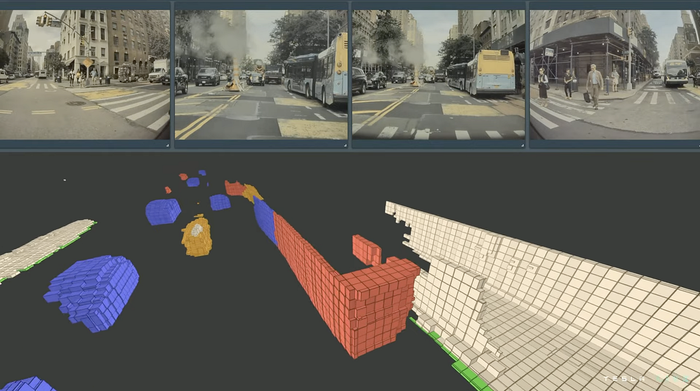

2022年,特斯拉提出Occupancy Network(占用网络),引入了“体素”的概念——三维空间基本单元,通过占用网络进一步提升对物体体积信息的识别能力。大幅改进此前视觉算法常常会出现误检、漏检的问题,同时,特斯拉也不断投喂各类场景的视频,让AI算法尽可能多的认识更广泛的驾驶情况。

2024年3月1日,特斯拉FSD v12完成更新,有业内人士表示,FSD v12是特斯拉史上最重要的一次更新,它为特斯拉车辆带来了前所未有的自动驾驶能力。

“FSD Beta v12将城市街道驾驶堆栈升级为端到端神经网络,经过数百万个视频训练,取代了30多万行C++代码。”在更新说明中,特斯拉如此说道。FSD v12被视为改变规则的技术,整个系统中端到端的算法几乎全部采用神经网络构建,其优势在于其灵活度非常高、应变能力好、上限高,并且可以通过高度拟人化的状态驾驶,大幅提升驾乘体验。

与特斯拉不同的是,国内厂商普遍采取的是激光雷达方案,这个方案依托激光雷达+摄像头+毫米波/超声波雷达等硬件设备,依靠实时测绘、AI算法的融合感知,来实现智能驾驶。比如,华为问界系列、理想汽车2024款L系列的Pro版、极氪007、阿维塔12、小鹏G9、问界M5等。

中国车企关于智能驾驶的技术主线比较简单,雷达的装载量越来越多,雷达的线程越来越高,成本越来越低。由此带动的,智能驾驶技术也不断由高价车向低价车渗透,乘联会发布的汽车智能网联洞察报告数据显示,2023年全年新能源乘用车中,装备L2级及以上辅助驾驶功能的比例达到55.3%。

而随着雷达路线的不断进步,2024年中国车企们开始大规模“进城”了,极氪007、阿维塔12、小鹏G9、华为问界等都已经开通了城市和高速NOA功能。城市场景下的自动驾驶具有重大的现实意义和象征意义,“进城”也被认为是迈进高阶自动驾驶的重要标志。

不过,从特斯拉的开发经验来看,端到端自动驾驶所需的数据规模、算力规模远远超出国内企业的承受能力。除了成本高昂,端到端自动驾驶的技术难度也非常之高,想要实现端到端产品落地和持续进化,对于车企的技术迭代能力也提出了更高的要求。

小模型VS大模型

智能驾驶行业,经历了一个模型“从小到大”的过程。

目前已量产的智能驾驶,绝大多数采用的是模块化架构。简而言之,模块化是将智能驾驶系统拆分为多个典型任务,并由专门的AI模型或模块处理。

现阶段的自动驾驶模型框架主要由感知、决策、控制三个部分组成。感知模块就像是人的眼睛和耳朵,负责对外部环境进行感知;控制模块就像人的双手和双脚,负责最终的加减速、转向等操作;而决策规划模块就像人的大脑,基于接收到的感知等信息进行行为决策和轨迹生成。

在此架构下,每个大模块可能包含多个小模型的组合。如感知模块可能包含分类、追踪和定位等不同AI模型,各司其职。

不过,随着软硬件升级与逐步深入,自动驾驶对于计算能力和海量数据处理能力的需求暴增,传统各个小模型“堆叠”的方案,已经无法满足城市自动驾驶的需求。比如,“堆叠”造成信息失真以及算力浪费,而每个小模型的技术天花板也会导致整体解决方案受限。

这个时候,大模型开始进入业界视野。

2021年8月,特斯拉AI高级总监Andrej Karpathy展示了一项新技术——基于Transformer的BEV(鸟瞰视角)感知方案,这是大模型技术首次应用于自动驾驶领域,也是特斯拉实现纯视觉智能驾驶方案的关键。

BEV可以实现将360度环视的时间、空间融合,相当于车辆正上方10-20米有一个直升机俯视车辆与周围环境。Transformer架构可以输出静态、动态信息,以及端到端的预测能力。更具象化来说,就是将摄像头、毫米波雷达、激光雷达等感知元件采集到的实时数据通过Transformer模型转换成3D图景,最后形成车辆周围的鸟瞰图,实现对车辆周边环境的精准感知,甚至可以实时形成一张车辆周围的实时地图。

需要指出的是,Transformer不等于大模型,它是模型的底座,目前的大模型都是在Transformer的基础上进行开发的。

在特斯拉使用Transformer之后,大模型早已经不限于智能驾驶感知领域。目前,智能驾驶已从仅使用模型进行图像感知,使用规则算法的方式,转变为感知、融合、预测全面使用模型。

尽管BEV+Transformer相较于过往的智驾技术路线优势众多,但也并非十全十美,仍存在诸多挑战。

首先,为了确保视觉感知重叠,汽车感知硬件中摄像头数量会有所提升,硬件成本增加。

其次,Transformer模型体量庞大,运算会消耗大量存储与带宽空间。同时对芯片性能要求严苛,除需进行算子适配以及底层软件优化外,SOC层面还需对缓存与带宽进行提升。

最后,也是最为重要的是Transformer训练与迭代需要海量数据做支撑,催生出海量的数据采集、标注需求。

从高速场景拓展到城市场景,车辆所遇到的长尾问题大幅增加。高速场景相对封闭,交通参与者相对简单不涉及行人,驾驶状态可预测性更强,对数据规模与多样性要求较低。而城市场景路况则较为复杂,交通参与者众多,场景异质性强,驾驶状态很难进行预测。因此,城市NOA对自动驾驶模型的泛化能力提出了更高的要求。

Transformer大模型量变到引起质变需要数亿公里标注数据的投喂,并覆盖不断出现的极端案例,才能实现自动驾驶感知算法从轻量的神经网络二维感知到基于Transformer四维感知的升维,这对数据标注量产规模提出了更高的要求,数据闭环能力取代算法范式,成为决定商业量产从1到N的胜负关键。

智能驾驶的另一条路径

在智能驾驶产业在发展过程中,数据端和算法端都面临着一定的发展痛点。

数据处理层面,自动驾驶所需要的数据是有价值的极端案例(Corner Case), 但当前数据处理面临的最大问题是低效率和高成本,无法实现数据闭环。其中,低效率的问题主要是高价值数据比例低、各类型数据需求同步难、数据处理的自动化程度低;高成本问题主要是数据采集成本高、数据标注成本高、数据存储成本高。

算法模型层面,自动驾驶功能逐步迈向高阶功能,自动驾驶系统将承担驾驶操作和周边监控,人类驾驶员将承担突发状况下的驾驶工作,此时感知和定位的工作将转移到车端,整个自动驾驶系统被认为是不安全的,使得整个高阶自动驾驶陷入了一个低谷中。以城区NOA为例,车辆将面对更复杂的场景及工况,包括更多的交通参与者、更复杂的交通规则、更高要求的地域覆盖率等。

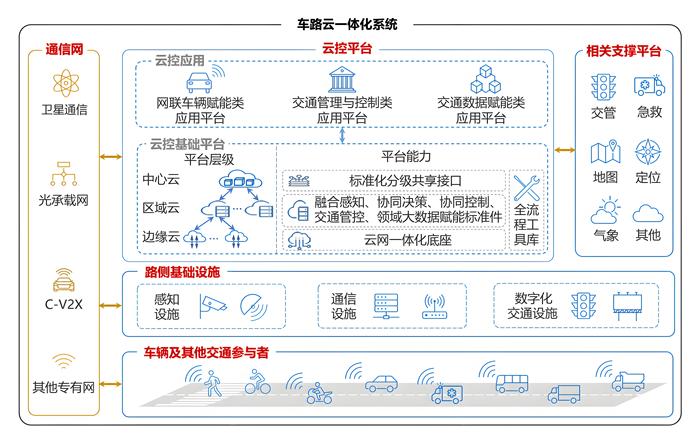

任何技术路线都不止一条,车路云一体化作为智能驾驶的另一条技术路径被摆到了前台。车路云一体化是在车路协同的基础上进一步发展而来,其关键是人、车、路、云,对应的是交通参与者、车载终端、路侧设施和云计算。一体化是将这些要素融合为一体,通过配备智能传感器设施的道路与智能网联汽车联动,类似于ETC系统中的路侧单元和车载模块的交互,在智慧公路获取到车辆数据之后,再回传到后台进行数据分析,进而得到实时路况信息,再下发给智能车辆、交通部门、城市管理者等相关方,实现全面的系统协同感知、决策与控制。

从以端到端大模型为代表的单车智能与车路云一体化两者关系来看,其本质上并非同维竞争。单车智能是“点”的提升,车路协同是“面”的统筹。车路云一体化诞生之初就是为了解决单车智能无法解决的问题,二者的关系是相互促进、互为补充。车路云一体化可以弥补单车智能在复杂场景下的感知不足,通过整合交通关键要素、超视距感知、实时信息共享等方式,提高自动驾驶的可靠性和安全性。

车路云一体化为自动驾驶大模型训练开辟了新的路径。与传统依赖车辆单独采集数据的方式相比,车路云一体化系统能够收集到更庞大的数据量与更丰富的数据类型,不仅大幅拓宽了训练数据的广度与深度,还显著加速了自动驾驶模型的学习效率与精确度,为实现更高水平的自动驾驶奠定坚实基础。

通过车路云一体化,自动驾驶车辆的传感器不再是唯一的眼睛,通过遮蔽或关闭这些传感器,车辆完全可以依赖路侧基站构建的实时数字孪生系统,将实时路况和环境数据源源不断地传输给车辆,指引其顺利完成自动驾驶任务。

目前,车路云一体化主要面临“两率低”问题,即路侧设备覆盖率不高且不均匀和车端设备渗透率低。一方面,C-V2X车联网路侧基础设施RSU覆盖率较低,未形成规模部署,缺乏全域打通;另一方面,车载终端渗透率较低,导致车辆间信息交互和协作能力不强。车路城协同基础设施建设主要集中在各城市示范区的部分道路路段,无法形成连续的智能网联环境,难以满足智能网联车辆规模化测试验证、数据训练、功能优化等需求,进而导致基础设施使用率偏低。

而中国庞大的公路网络以及机动车保有量为车路云一体化提供了丰富的验证场景和数据来源。2023年,全国公路总里程544万公里,其中高速公路18万公里,机动车保有量是4.35亿辆。据《车路云一体化智能网联汽车产业产值增量预测》报告预测,2025年/2030年我国车路云一体化智能网联汽车产业总产值增量分别为7295亿元/25825亿元,年均复合增长率为28.8%。

所有的技术路线最终都将殊途同归。当前,端到端大模型和车路云一体化还处于不断进化的阶段,但其目标都是为了让更安全的自动驾驶走进千家万户。随着越来越多的企业投入到相关技术的研发与应用当中,这些技术的未来发展图景也将愈发清晰。如今,智能驾驶起跑的枪声已经打响,路线是关键,而朝着选好的方向狂奔,也是赛道当中的企业不得不做的选择。

评论