文 | 窄播 李威

这是《窄播Weekly》的第31期,本期我们关注的商业动态是:AI视频生成大模型。

今年2月OpenAI通过Sora的发布,为AI视频生成明确了依靠DiT(Difffusion Transfomer)架构获得突破的技术路径。随后,快手、阿里巴巴、字节跳动、美图、生数科技、智谱AI、MiniMax纷纷入局其中,持续提升着AI视频生成的赛道热度。

9月,国产视频生成大模型迎来了目前最重要的一轮爆发:

8月31日,MiniMax正式发布视频模型video-01,拉开了红毯仪式的序幕。

9月19日,阿里云CTO周靖人在云栖大会上发布全新视频生成模型。同日,快手发布可灵1.5模型,内部评测整体效果比可灵1.0模型提升了95%。

9月23日,美图公司宣布美图奇想大模型完成视频生成能力的升级。

9月24日,字节跳动旗下火山引擎发布了PixelDance和Seaweed两款视频生成大模型。

9月26日,美图公司又向所有用户开放了AI短片创作工具MOKI。

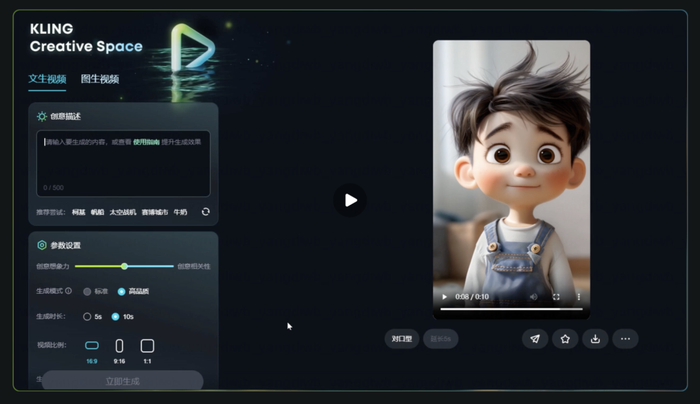

9月30日,可灵又上线了「对口型」功能,支持对生成的人物上传音频内容,并宣布正式全面开放API,上线了AI创作社区「创意圈」。

国庆假期,国外视频生成大模型领域也迎来了新变化。当地时间10月4日,Sora团队研发负责人Tim Brooks宣布离职加入DeepMind,继续从事视频生成和世界模拟器方面的工作。

同日,Meta对外公布了新的大模型Movie Gen。该模型支持根据文本提示创作视频和音频内容,并允许用户添加特效、道具、服装或对生成内容中的部分元素进行简单调整,可生成最长16秒的1080P视频。Meta认为,Movie Gen旨在处理从个性化视频创作到复杂的视频编辑和高质量音频生成等任务,并计划于2025年在Instagram落地应用。

从国内到国外,巨头与创业公司携手结束了视频生成大模型你方唱罢我登场的红毯仪式,开始面向具体场景寻找快速落地、生效、获益的路径。

四个共性特征

在过去的7个月时间里,不同企业围绕视频生成大模型进行的探索呈现出了四个共性特征。

第一,视频生成大模型的迭代速度更快,效果提升更显著。从单一模型来看,快手可灵截止1.5版本发布,已经进行了9次迭代,并且在上线1.5模型的同时,还在为1.0模型增加新的能力。从不同模型来看,近期发布的视频生成大模型在生成效果上都有比较明显的提升。

第二,几乎所有视频生成大模型都是现货供应,极少有像Sora一样的期货产品。阿里巴巴发布视频生成大模型之后,即日就能在通义App和通义万相网站上面向所有用户开放。字节跳动的视频生成大模型发布之后,火山引擎总裁谭待也表示,豆包视频生成大模型不是「期货」,已经在内测API和应用,国庆节后会放出更多公开API。

第三,现货的前提下,全量开放和限制次数的免费使用成为国产视频生成大模型的共同选择。可灵在7月23日就实现了全量开放,非会员每日登陆可以获得6个视频生成份额。阿里强调视频生成功能在手机App端不限量免费使用。MiniMax也在海螺AI官网上开启了对视频生成功能的限免体验。相较而言,每月向Runway支付105元,才可以获得生成10个视频的权益。

第四,可生成的视频类型越来越丰富,清晰度越来越高,细节越来越逼真,视频一致性和长度不断提升,运动轨迹越来越符合物理规律。

可灵1.5模型支持最长2分钟的30帧1080P高清视频。豆包视频生成大模型支持生成黑白、3D动画、2D动画、国画等多种风格、适配不同画幅比例的视频内容。通义视频生成大模型支持最长5秒、每秒30帧的720P视频生成,并能生成与画面匹配的音效,呈现发丝随风飘动、水滴上的阳光折射等细节。

这些共性特征特征的出现意味着,不同于OpenAI在Sora上展现出了「世界模拟器」的野心,国产的视频生成大模型从诞生起,就选择的是一条更落地、更现实的进化路径——让快速迭代的视频生成大模型融入和优化现有的视频创作流程。

对于大模型创业公司而言,就像MiniMax创始人闫俊杰所说,人类每天消费的大部分内容都是图文和视频,文字的占比并不高,具备输出多模态内容能力的大模型能够获得更高的用户覆盖度和使用度。

对于拥有视频业务和用户积累的成熟企业而言,大模型可能意味着一个重新分配蛋糕的机会,也意味着深挖已有用户潜力的可能,最不济,对大模型的投入也能够在一定程度上帮助企业降低被挤下牌桌的风险。

不同大模型有不同的突破口

从差异性上来看,内容平台在视频生成大模型上已经展现出了一定的优势。从Sora发布至今,快手的可灵与字节跳动的豆包视频生成大模型分别在两个不同的时间点收获了最高光的关注。并且,可灵和豆包视频生成大模型拿出的功能特点更能切中实际的使用需求。

可灵1.5模型可以一次性生成最多4条视频,提升了抽卡效率,图生视频的时长也提高到了10秒,还上线了「使用指南」,降低用户使用可灵的门槛。可灵1.0模型的图生视频功能增加了运动笔刷功能,让用户能为图中最多6个元素描绘更精准的运动轨迹。

相较效果丰富的Seaweed,另一款基于DiT架构的豆包视频生成大模型PixelDance给到了大家更大震撼。该模型展示出了对复杂prompt的精准理解能力,也更接近真实视频创作习惯的动态效果与镜头语言,能够在同一个prompt下实现多镜头的切换,并保持主体、风格、氛围的一致性。

发布会的展示中,PixelDance可以根据「一个男人站在一辆汽车前面,镜头向前推进,聚焦到男人拿出的钥匙,男人打开车门」这样的prompt,生成一个基本呈现其细节要求的10秒钟视频。在已经发布的测评中,PixelDance也生成了高一致性,且能运用变焦、缩放、摇移等多种镜头语言的视频内容。

相较视频平台,拥有图像工具产品基础的美图公司,将AI短剧生成作为自己视频生成大模型能力的突破口。其面向所有用户开放的AI短片创作工具MOKI,支持生成中国动画、儿童期刊、手绘插画、日式动漫、古典水墨等10种视觉风格的短剧作品。从一些测评来看,其对宫崎骏动画风格、黏土动画风格都有不错的呈现。

阿里巴巴的通义视频生成大模型、MiniMax的video-01主要强调了模型底层能力的优化。阿里巴巴采用了中英文双语标注,从语义理解环节就强化了对中文表达的支持,对中国风视频内容的生成有更好的支持,并能对简单的prompt进行灵感扩写,提升视频生成的效果。MiniMax则会强调生成的视频内容可媲美电影质感。

奔向场景的三条路径

随着玩家的基本聚齐,视频生成大模型的竞争开始进入到寻找规模化落地场景的阶段。我们可以为视频生成大模型找到从C端到B端的丰富的应用场景,比如朋友圈内容、AI短剧、视频广告、口播内容、宣传片、节目制作、电影后期……这些场景大致可以被划分为三类,也是大模型奔赴场景的三条路径。

第一,直面普通用户,寻求快速增长。快手在快影上、字节跳动在即梦AI上,都在进行着直接面向普通用户的探索。但是,对于大多数普通用户来说,视频剪辑、视频生成都不是高频次的功能,需要以更大的用户基数来对冲大部分用户使用频次的不足。

以视频生成大模型目前的能力水准,并不足以满足用户简单便捷地生成所需视频内容的要求。提出能生成有效视频内容的prompt,对大部分人都还是一种挑战。这也是为什么,阿里会在视频大模型中增加灵感扩写功能。视频生成大模型还处在PS阶段,但大部分用户需要的是美图秀秀。

这种落差的存在,让视频生成大模型面向普通用户的使用,更多会从某个极其具体且刚需的场景切入。像之前大火过的妙鸭相机、黏土特效以及能让照片说话唱歌的EMO模型,都属于具体且刚需的娱乐场景。他们还肩负着让更多普通用户对大模型产品形成精准预期的责任。

在此基础上,从有趣向有用过渡,不断找到具体且刚需的场景,可能是视频生成大模型面向普通用户进行拓展的关键。

第二,服务个体的创作者,降低创作门槛。这类用户往往是个人或小团队,创作需求更持续,更有创作冲动,却缺乏生产高成本、高概念视频作品的能力。视频生成大模型让这些个体创作者有机会付出更多时间成本,通过精调prompt和抽卡,来降低金钱成本,将更多灵感和想象力转化为视频作品。

对于视频平台而言,这些撑起内容创作生态基础的个体创作者,是最重要的服务对象。更低的视频创作门槛,更丰富多彩的灵感表达,意味着更为繁荣的视频内容生态。剪映、即梦AI、快影、YouTube、Instagram正在融入的视频生成大模型能力,甚至美图公司的MOKI,都会将服务这部分创作者作为一个重点。

即梦AI和剪映市场负责人陈欣然在活动上展示了一个融合AI能力的创作流程。在这个流程中,创作者可以利用AI生成一个故事脚本,然后在AI辅助下完成视觉设定,在故事脚本和视觉设定基础上生成视频内容,并配以AI生成的音乐和音效,利用AI智能剪辑输出完整作品。这种理想的视频创作的工作流能够极大释放创作者的潜力。

YouTube也在将Google的视频生成大模型能力融入其中。2023年,YouTube就已经支持创作者通过自然语言在短视频平台YouTube Shorts中生成视频背景。今年,随着对AI视频生成大模型Veo的集成,创作者可以为YouTube Shorts生成6秒的短片,或者为视频添加过渡场景。

第三,服务企业客户,将视频生成能力植入到现有的内容生产流程中,提供辅助,降低成本。可灵与东方卫视合作,在中秋晚会的《博物馆奇妙夜》节目中,让文物都「活」了过来,支撑了创意的实现。利用剪映的内容营销创作工具,用户上传商品素材或页面链接,就能一键生成不同风格的带货视频。

东吴证券在研报中认为,AI渗透率提升的核心驱动力在于企业的降本增效诉求。根据东吴证券的测算,全AI模式下,电影、长剧、动画片、短剧的制作成本分别为2.5/9.3/3.7/0.4万元人民币,相较于传统模式成本降低幅度超95%;人机共创模式下,电影制作成本有望降低43%。

Runway与狮门影业的合作表明企业与视频生成大模型结合的意愿在提升。在这个合作中,Runway将使用狮门影业的电影目录来训练自定义视频模型,使其可以生成电影视频,并利用其增强创作者的作品。当然,这个探索需要更长时间,并具备很强的不确定性。

尽管一些创作者反对将其作品应用于大模型的训练,但2024年动画艺术家工会(Animation Guild)对美国55万名影视行业从业者进行的问卷调查显示,已经有69%的公司在使用生成式AI技术,其中约44%的公司将其应用于生成3D模型,39% 的公司应用于设计角色和环境。

需要更多成功模板

从Runway与狮门影业的合作中,我们也可以看到一个趋势。在视频生成大模型之上,一个视频生成大模型的应用生态正在出现。将视频生成大模型的能力针对特定场景进行模板化,是这个应用生态的最核心工作。Runway就有意将和狮门影业共同开发的模型授权为模版,供个人创作者构建和训练自己的自定义模型。

美图公司对MOKI的功能设计就是一个细分场景模板化的案例。MOKI将创意短片的创作过程分成可以进行微调的三个步骤:通过用户提供的故事梗概和现成脚本生成分镜脚本和设定选项;根据分镜脚本生成画面,并支持修改细节;最后输出带有配乐的视频内容。

另一种模板化的路径是与行业顶尖的创作者合作,推出最佳实践。快手在不久前宣布启动「可灵AI」导演共创计划,联合李少红、贾樟柯、叶锦添、薛晓路、俞白眉、董润年、张吃鱼、王子川、王卯卯9位导演,依托可灵的技术能力,制作出品9部AIGC电影短片。其中沉淀出来的最佳实践,也能为更多内容创作者使用可灵提供借鉴。

我们也看到,越来越多的视频生成大模型开始面向企业开放API接口,借助更多企业的力量,共同开发视频生成大模型的场景化模板。Runway 为其视频生成大模型Gen-3 Alpha Turbo开放了仅限受邀者使用的API接口,供受邀者在应用中构建视频生成功能。Luma、Vidu也都推出了自己的API开放计划。

在过去半年多的时间里,我们见证了视频生成大模型的快速迭代发展,也看到了人们为其寻找最佳应用场景的诸多努力。在视频生成大模型领域,还有很多不确定性,比如现有的技术路径是否能够实现视频生成能力的最大化,会不会有新的技术路径出现,以及如果将视频生成能力融入进Butterflies这样的AI社区会产生什么样的效果。这需要更多时间去探索和验证。

评论