记者 |

主导人工智能(AI)计算的英伟达,再度从软、硬件两端拓展产业布局,构建其“全栈”计算生态。

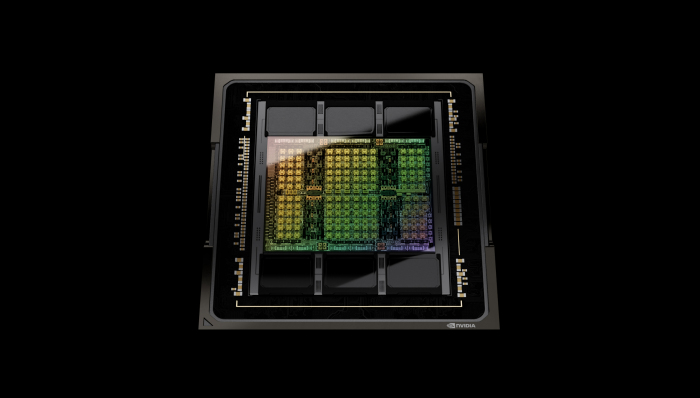

时隔近两年,芯片设计厂商英伟达于美国时间3月22日发布全新Hopper架构GPU(图形处理器)H100,其主要用于数据中心,现已投入生产,将于第三季度上市。

H100由台积电代工,采用4纳米制程,内含800亿个晶体管。英伟达称,新架构GPU的亮点在于搭载名为“Transfomer Engine”的AI计算核心,可大幅加速AI计算性能;安全性方面,通过机密计算功能,可保护企业AI模型和客户数据。借助NVLink网络连接技术,可达到近5TB每秒的外部数据传输速度,进一步加速数据处理。

此次英伟达更新GPU,为竞争对手再次立下标杆。在半精度、单精度、双精度浮点等人工智能常用计算模型上,性能可达前代产品A100的3倍,而在FP8 Tensor Core技术上,性能甚至可达A100的6倍,远高于近年国内厂商发布的AI专用计算芯片。不过,H100的最大设计功耗也达到了700瓦。

英伟达称,国内的阿里云、腾讯云、百度智能云和海外的亚马逊云科技(AWS)、微软Azure、谷歌云等云服务商都计划提供基于H100的服务和云端实例。而将为H100制造服务器的厂商包括思科、戴尔、浪潮、联想、新华三等。英伟达还为H100配置多种规格,满足多种带宽、接口标准。

基于英伟达在网络互联技术的投资,H100的数据处理能力有了大幅提高。“20个H100 GPU便可承载相当于全球互联网的流量,使其能够帮助客户推出先进的推荐系统以及实时运行数据推理大型语言模型。”英伟达CEO黄仁勋称。

GPU以外,英伟达也对其自研CPU(中央处理器)产品进展进行重点介绍,黄仁勋称其为Grace超级芯片,是英伟达首款高性能计算用途CPU。Grace CPU采用Arm v9架构,内含144个Arm核心,提供最高的单线程核心效能,支持Arm新一代的向量扩充指令集。在服务器上,Grace CPU还可搭配英伟达DPU、GPU、智能网卡等产品,构成整体解决方案。

至此,基于CPU、GPU两大新品,英伟达在数据中心的计算架构得以完整呈现。目前,在服务器CPU领域,市场仍为英特尔、AMD的x86新品所支配。而黄仁勋表示,Grace CPU面向高性能计算细分市场,如科学计算、数据分析等。在云计算、企业级计算、边缘计算、工作站、个人电脑领域仍以现有CPU为主。

发布会上,黄仁勋还提出基于Hopper架构GPU和Grace CPU的“AI工厂”构想,并称为数据中心的变革方向:企业以工业化规模提高数据中心AI算力,持续提炼数据,进行训练和完善AI模型,实现AI能力大规模输出。

英伟达还宣布了其新超算系统Eos,该系统预计在今年晚些时候开始运行,比日本的“富岳”超级计算机还要快4倍,有望成为世界上最快的人工智能超算系统。

面向数据中心市场,两大老牌芯片厂商英特尔和AMD仍有望正面阻击英伟达。2021年6月,英特尔成立加速运算系统与绘图处理事业群(AXG)。而在今年2月召开的投资者大会上,英特尔披露该事业群下三个子部门正按计划出货产品,涉及图形计算、高性能计算与人工智能计算产品,预计2022年度将为公司带来超过10亿美元的营收。

AMD方面,在2011年11月,AMD宣布其Instinct MI200系列加速卡和ROCm 5配套软件上市,面向数据中芯加速计算市场。今年2月,AMD完成收购可编程芯片公司赛灵思,应对数据中心应用场景的计算任务已呈现更加多样化趋势。

评论