界面新闻记者 |

近日,微软开源DeepSpeed Chat的消息再次引发AI圈的关注。

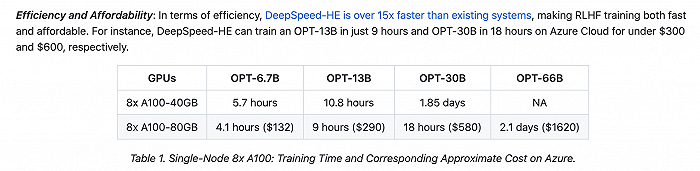

DeepSpeed Chat基于微软的DeepSpeed深度学习优化库开发而成,具备训练、强化推理等功能,其使用了RLHF(基于人类反馈对语言模型进行强化学习)技术,可以将训练速度提升15倍以上,同时大幅降低成本。根据微软DeepSpeed组的官方介绍,DeepSpeed-Chat具有三大核心功能:简化ChatGPT类型模型的训练和强化推理体验、DeepSpeed-RLHF模块和DeepSpeed-RLHF系统。

在ChatGPT走向大众视野之后,大模型背后的算力和训练成本继而成为焦点。

国金证券测算的数据显示,在通用大模型训练方面,使用云计算时ChatGPT的训练成本约为170万美元,若自建AI算力中心进行模型训练,训练成本有望降至约51万美元;在大模型推理方面,使用云计算时的ChatGPT每处理1000Tokens信息需花费约0.177美分,自建AI算力中心有望将成本降至0.053美分。

今年3月1日,OpenAI宣布开放ChatGPT API接口,允许第三方开发者通过API将ChatGPT功能集成到自己的应用程序和服务中。该接口对每1000字符处理单元收费0.002美元,即支付两美元可处理约75万个英文单词。OpenAI称,新模型较GPT-3.5模型便宜10倍,成本下降主要因为团队去年12月以来进行一系列的系统优化。

此前,开源社区已经推出过LLaMA、Alpaca、Vicuna、Databricks-Dolly等模型,让更多人用上ChatGPT。不过,由于缺乏支持端到端的RLHF规模化系统,类ChatGPT模型的训练依然存在不小的阻碍。

DeepSpeed方面表示,尽管开源社区付出了巨大的努力,但目前仍缺乏一个支持端到端的RLHF规模化系统,这使得训练强大的类ChatGPT模型十分困难。

例如,用现有的系统训练一个适度的6.7B ChatGPT模型,通常需要昂贵的多GPU设置,这是许多数据科学家无法做到的。即使有这样的计算资源,训练效率也往往低于这些机器所能达到的5%。即使有多GPU集群,现有的解决方案也无法做到简单、快速和经济实惠地训练具有数千亿个参数的最先进的ChatGPT模型。

为了让ChatGPT这样的模型更容易被普通数据科学家和研究者使用,并使RLHF训练真正普及到AI社区,他们发布了DeepSpeed-Chat。

而在微软开源DeepSpeed Chat之后,普通用户可以通过简单的操作训练类ChatGPT等大语言模型。数据显示,只需要花费1620美元,就可以通过混合引擎DeepSpeed-HE,在2.1天内训练一个OPT-66B模型;如果使用多节点、多GPU系统,DeepSpeed-HE可以花320美元,在1.25小时内训练一个OPT-13B模型,花费5120美元,在不到一天的时间内训练一个OPT-175B模型。

这也是AI界为之振奋的原因。在微软开源DeepSpeed Chat之后,更多人开始有机会直接上手训练大模型。对于需要更多数据训练的AI行业来说,也将是一次重要的节点。

评论